куда сдавать в 2019 году

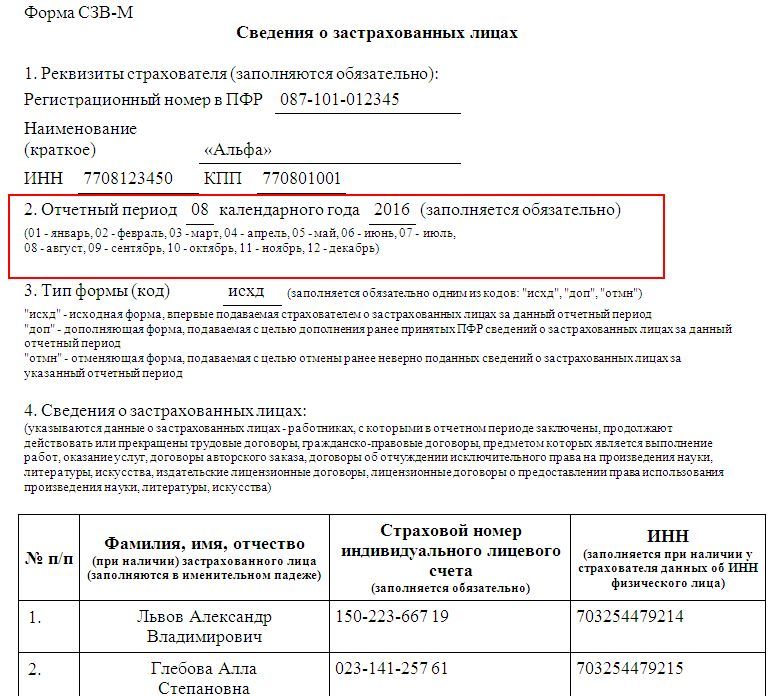

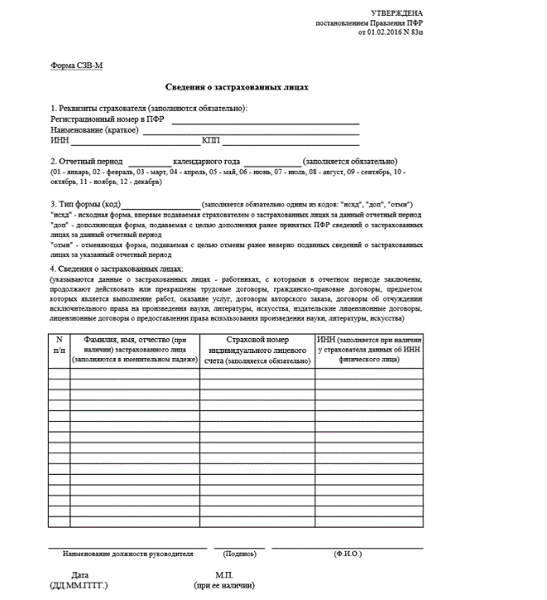

Одна из форм персонифицированной отчетности – СЗВ-М. Куда сдавать этот отчет? Каков порядок сдачи, если у компании есть удаленно расположенные обособленные подразделения? На эти и другие вопросы ответим в статье.

Голова и обособки

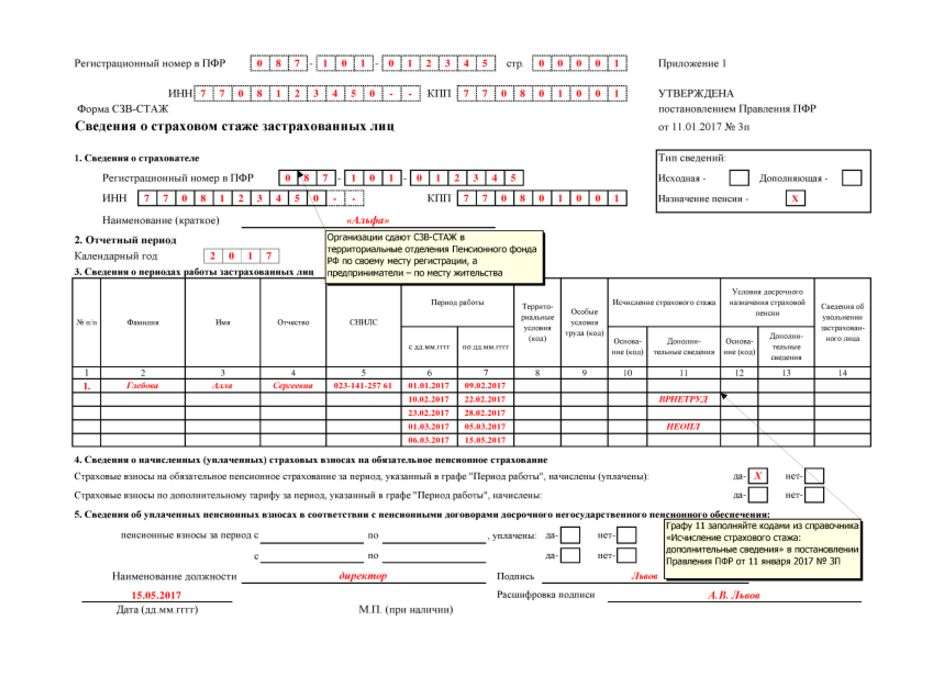

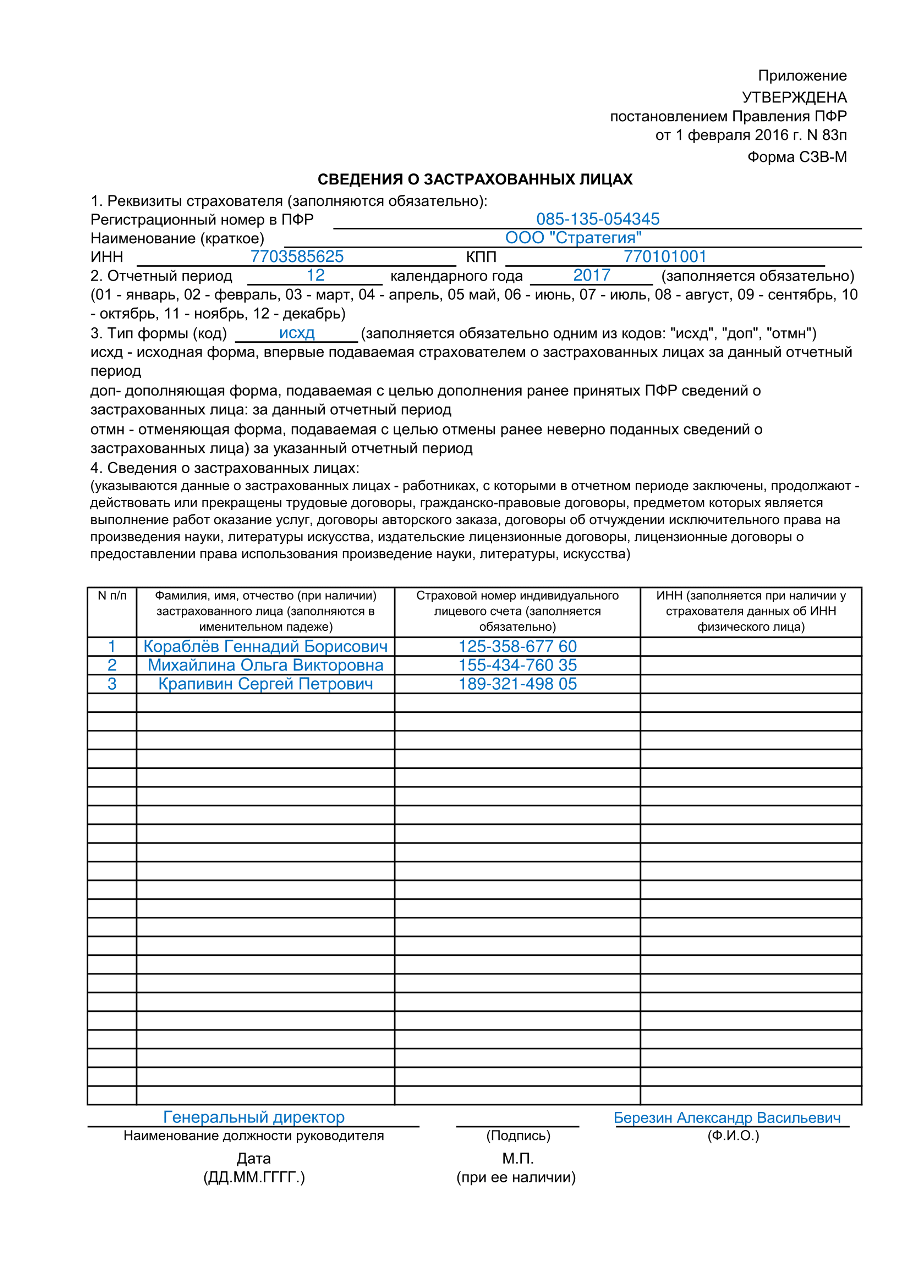

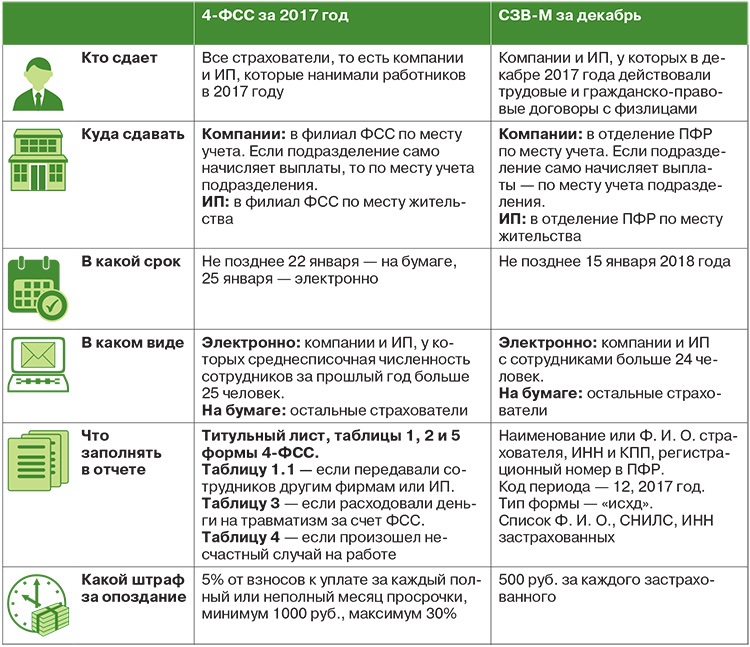

По общему правилу форму нужно сдать в территориальное отделение Пенсионного фонда по месту учета страхователя. Куда сдавать СЗВ-М в 2019 году? В то отделение, где зарегистрирован работодатель.

Под страхователями для целей сдачи данной отчетности понимаются организации и индивидуальные предприниматели, заключившие трудовые и гражданско-правовые договоры с физическими лицами. Если в каком-то месяце компания не ведет деятельность, то это не освобождает ее от необходимости своевременно подать отчет.

С организациями, у которых нет обособленных подразделений все понятно, а куда сдавать СЗВ-М по обособленному подразделению в 2019 году? Если обособка имеет отдельный расчетный счет и начисляет вознаграждения персоналу самостоятельно, то сдавать форму нужно в территориальное отделение Пенсионного фонда по местонахождению такого подразделения.

В противном случае, если у обособки нет своего счета, или начисление зарплаты происходит в головном отделении, то данные по сотрудникам такого подразделения нужно включить в общий отчет по головному предприятию. В аналогичном порядке сдается СЗВ-М по подразделениям, находящимся за границей (п. 11, 14 ст. 431 НК РФ, ст. 11 Федерального закона от 15.12.2001 № 167-ФЗ). Теперь вы знаете, куда сдавать отчет СЗВ-М в различных ситуациях.

Бумага или электронка

По закону сведения о физлицах можно сдать в электронной или бумажной форме. Если количество лиц, за которых подается отчет 25 человек и более, то выбора у организации нет. Форма сдается исключительно в электронном виде по формату, утвержденному постановлением Правления ПФР от 07.12.2016 № 1077п (п. 2 ст. 8 Федерального закона от 01.04.1996 № 27-ФЗ).

Сколько бы людей не было поименовано в отчете разбивать его на пачки не нужно. Вне зависимости от количества застрахованных сведения предоставляются одним файлом.

Если число физических лиц не превышает 24 человек, то страхователь может сдать отчет на бумаге. Куда сдавать СЗВ-М? В Пенсионный фонд по месту регистрации. Данные из бухгалтерской программы лучше сохранить на флэшку. Работники Пенсионного фонда могут попросить разнести данные в специальной программе самостоятельно и только после этого примут бумажный носитель.

Новости социальной поддержки

Порядок подачи и рассмотрения электронных обращений граждан

Обращение, направленное на официальный сайт Министерства по электронной почте, должно содержать фамилию, имя, отчество заявителя, почтовый адрес, по которому должен быть направлен ответ, контактный телефон, суть обращения (далее — Интернет-обращение).

Интернет-обращение, поступившее на официальный сайт по электронной почте, распечатывается, и в дальнейшем работа с ним ведется в установленном порядке в соответствии с Федеральным законом от 02.05.2006 г. N 59-ФЗ «О порядке рассмотрения обращений граждан Российской Федерации», административным регламентом предоставления министерством труда и социальной защиты населения Ставропольского края государственной услуги «Организация приема граждан, обеспечение своевременного и полного рассмотрения обращений граждан, принятие по ним решений и направление ответов заявителям в установленный законодательством Российской Федерации срок» (далее — Административный регламент).

Для приема Интернет-обращения заявителя в форме электронного сообщения применяется специализированное программное обеспечение, предусматривающее заполнение заявителем, реквизитов, необходимых для работы с обращениями и для письменного ответа. Адрес электронной почты заявителя (законного представителя) и электронная цифровая подпись являются дополнительной информацией.

Основаниями для отказа в рассмотрении Интернет-обращения, помимо указанных оснований, в пункте 2.9 Административного регламента, также являются:

- отсутствие адреса (почтового или электронного) для ответа;

- поступление дубликата уже принятого электронного сообщения;

- некорректность содержания электронного сообщения.

Ответ заявителю на Интернет-обращение может направляться как в письменной форме, так и в форме электронного сообщения.

Заявителю гарантируется не разглашение без его согласия сведений, содержащихся в Интернет-обращении, а также сведений, касающихся частной жизни гражданина. Информация о персональных данных заявителей хранится и обрабатывается с соблюдением требований российского законодательства о персональных данных.

Информация о персональных данных заявителей хранится и обрабатывается с соблюдением требований российского законодательства о персональных данных.

Интернет-обращения представляются руководству Министерства для рассмотрения. На наиболее часто задаваемые вопросы периодически публикуются ответы руководителей Министерства. Ваш вопрос, заданный в Интернет-обращении может быть опубликован на сайте в обезличенной форме.

Бизнес гибнет от бумаг

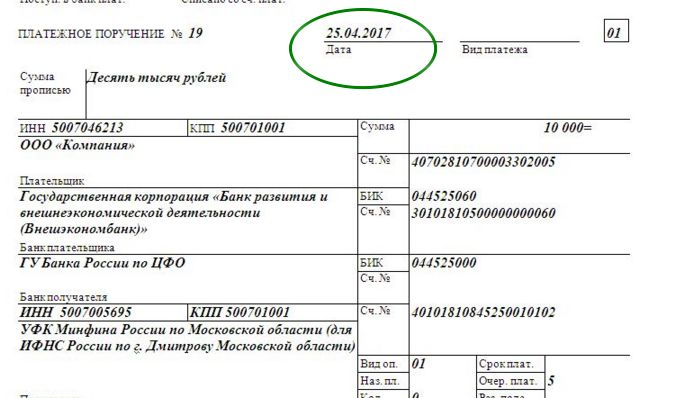

Предприниматели в России тонут в бумажной отчетности. Ежегодно только одна налоговая запрашивает от бизнесмена от одного до 11 документов. Кроме того, существует до 158 всевозможных форм статистики для разных видов деятельности. А еще отчеты бухгалтерские, пара бумаг для Фонда социального страхования, еще до четырех — для Пенсионного фонда, специальная ведомственная отчетность (например, в органы тарифного регулирования или документы об использовании средств долевого строительства, отчеты частных медицинских организаций в фонды ОМС, декларации об объеме производства и оборота алкогольной продукции и тому подобное).

Чем бизнес больше, тем выше стопка документов, которая может доходить до тысячи бумаг в пересчете на одну фирму. При этом табель форм федерального статистического наблюдения на 2020 год содержит более 60 отдельных дат сдачи отчетов. В рамках одного вида деятельности количество дат может доходить до 10 в год, а для многопрофильных предприятий — и того более. Для субъектов МСП рост нагрузки происходит скачкообразно: если микробизнесу требуется заполнять меньше форм, то малому и среднему — в несколько раз больше.

Предприниматели поголовно жалуются на то, что данные различных форм бумаг, предоставляемых с периодичностью ото дня до года, часто дублируют друг друга. Совокупные обязательства представляются избыточными, накладывают административное бремя на отдельные категории предпринимателей, а нарушение сроков сдачи часто несет риски получить существенный административный штраф.

Кстати, в этом году запущена сплошная перепись малого и среднего бизнеса. Хоть и ведется она в электронном формате, согласитесь, ведь тоже дополнительная нагрузка?! Мир уже давно начал уходить от традиционных концепций статистики — вся мировая система переходит на big data.

Элемент такой системы в России — ФНС, которая аккумулирует данные со всей страны с онлайн-касс и получает ежедневную картину потребления и активности малого бизнеса.

Поэтому с целью оптимизации процесса подачи различных видов отчетности представляется возможным создание «единого окна» на базе Федеральной налоговой службы России с обеспечением возможности электронного взаимодействия с предпринимателями и подачей всех документов в одну инстанцию. Для реализации указанного замысла, по мнению специалистов Партии Роста, необходимо:

- создать единый репозиторий отчетных данных на базе ФНС России, куда субъекты предпринимательства будут предоставлять все необходимые формы отчетности; заинтересованные ведомства, региональные и муниципальные органы власти будут получать необходимые данные из репозитория в рамках межведомственного взаимодействия;

- провести полную инвентаризацию форм отчетности и исключить избыточные и дублирующие друг друга формы, определив, таким образом, оптимальный набор отчетности, предоставляемой в репозиторий;

- обеспечить возможность передачи всех видов отчетности субъектами предпринимательства в единый репозиторий в электронном формате.

На законодательном уровне в ст. 13 и 14 Федерального закона от 27.07.2006 № 149-ФЗ «Об информации, информационных технологиях и о защите информации» установить приоритет программного (посредством API) доступа к порталам сдачи отчетности и иным государственным информационным системам, а также заблаговременной публикации любых изменений в формы и форматы предоставления данных в адрес госорганов.

На законодательном уровне в ст. 13 и 14 Федерального закона от 27.07.2006 № 149-ФЗ «Об информации, информационных технологиях и о защите информации» установить приоритет программного (посредством API) доступа к порталам сдачи отчетности и иным государственным информационным системам, а также заблаговременной публикации любых изменений в формы и форматы предоставления данных в адрес госорганов.

На практике это будет означать начало формирования единой системы big data в России под эгидой государства. Мы уверены, эта система сможет помочь оценивать степень достижения национальных целей и приоритетов, своевременно корректировать программы и перераспределять ресурсы, оценивать состояние секторов экономики. А бизнес сможет сдавать данные в удобном и понятном формате, что снизит административную нагрузку, особенно в непростой постпандемийный период.

Однако все понимают: чтобы реализовать этот достаточно глобальный план, уйдет немало времени. Поэтому в Партии Роста проанализировали и работу существующей системы отчетности. Вот какие точечные меры мы можем предложить.

Вот какие точечные меры мы можем предложить.

В связи с применением онлайн-касс:

- В ежемесячной форме статистического наблюдения Форма П-1 «Сведения о производстве и отгрузке товаров и услуг» исключить сведения по оборотам розничной торговли: Графы 1 и 2 строки 02 раздела 1, Графы 1 и 2 строки 22 Раздела 3, Раздел 5 полностью.

- В ежеквартальной форме статистического наблюдения Форма № 3-ТОРГ (ПМ) «Сведения об обороте розничной торговли малого предприятия» исключить: Графы 1 и 2 строка 01 Раздел 1, Графы 1 и 2 строка 02 Раздел 1, Графы 4 и 5 строки 66 Раздел 2.

- В годовой форме статистического наблюдения Форма 1-ТОРГ «Сведения о продаже товаров организациями оптовой и розничной торговли»: Раздел 2 исключить, Раздел 3 столбец 5 исключить, Графу 5 Раздел 4 полностью исключить.

- Провести анализ возможности перевода наблюдений в розничной торговле и услугах населению на межведомственный обмен данными (в связи с введением онлайн-касс).

- Годовая форма статистического наблюдения Форма № 12-Ф «Сведения об использовании денежных средств» дублирует годовую форму «Отчет о движении денежных средств» к годовому балансу.

Предлагаем по итогам 2020 года наладить обмен информацией между Росстатом и ФНС России для заполнения формы 12-Ф.

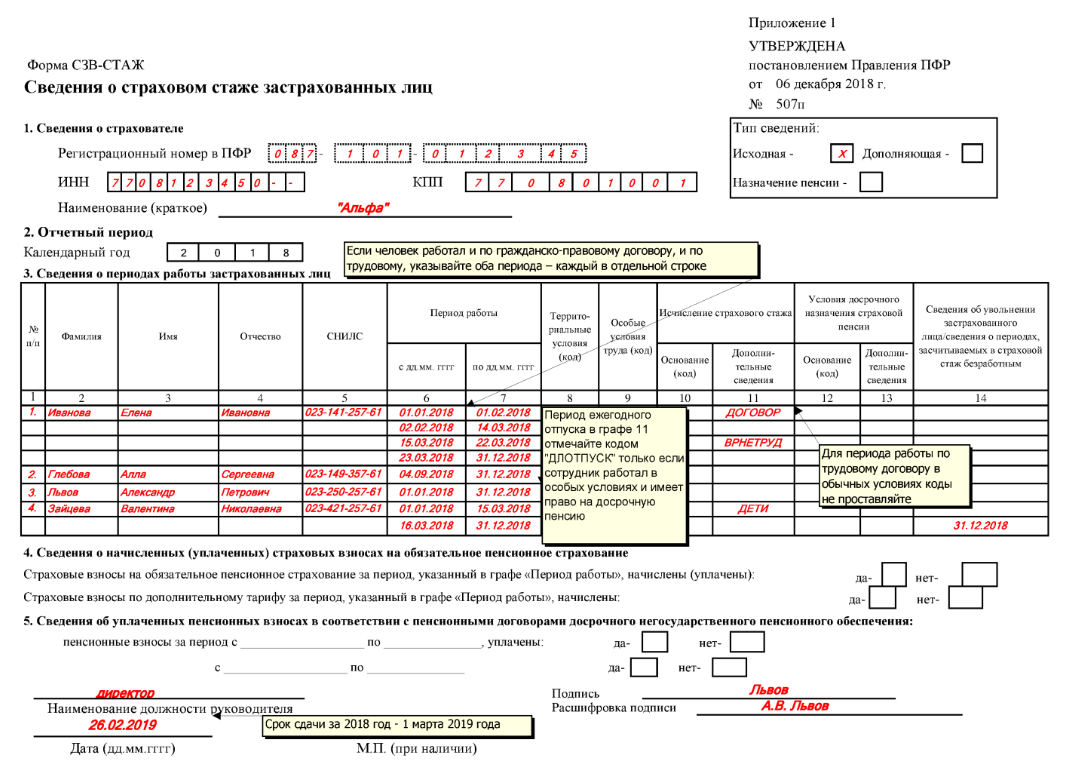

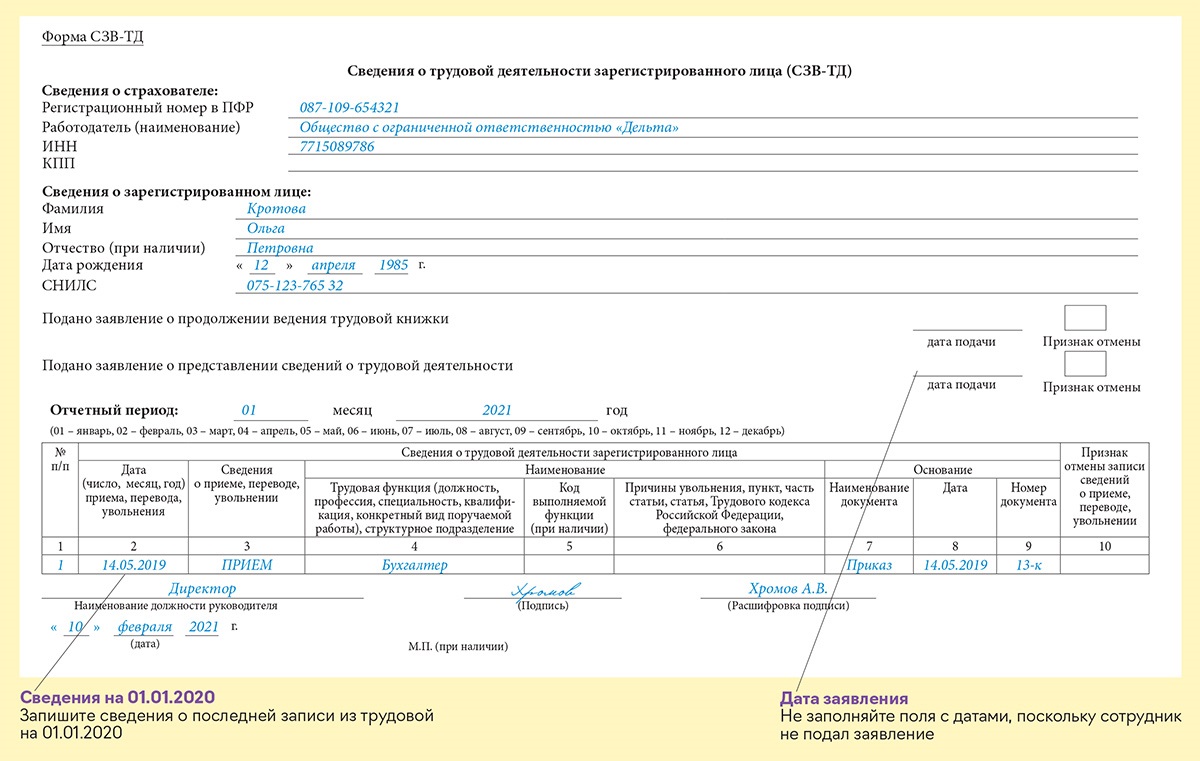

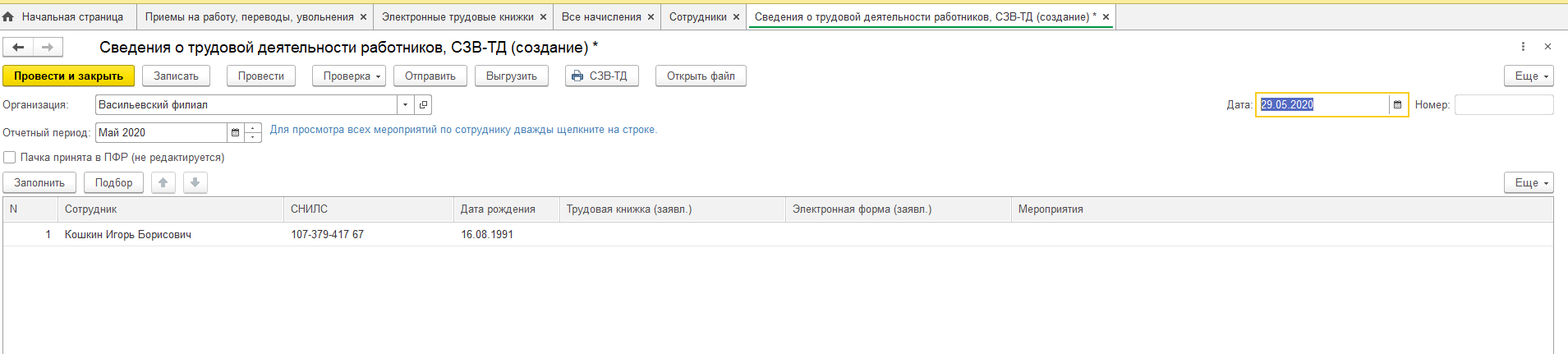

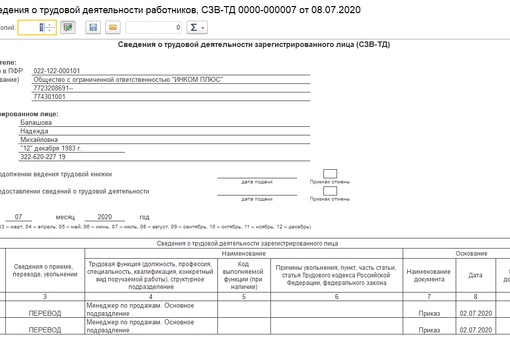

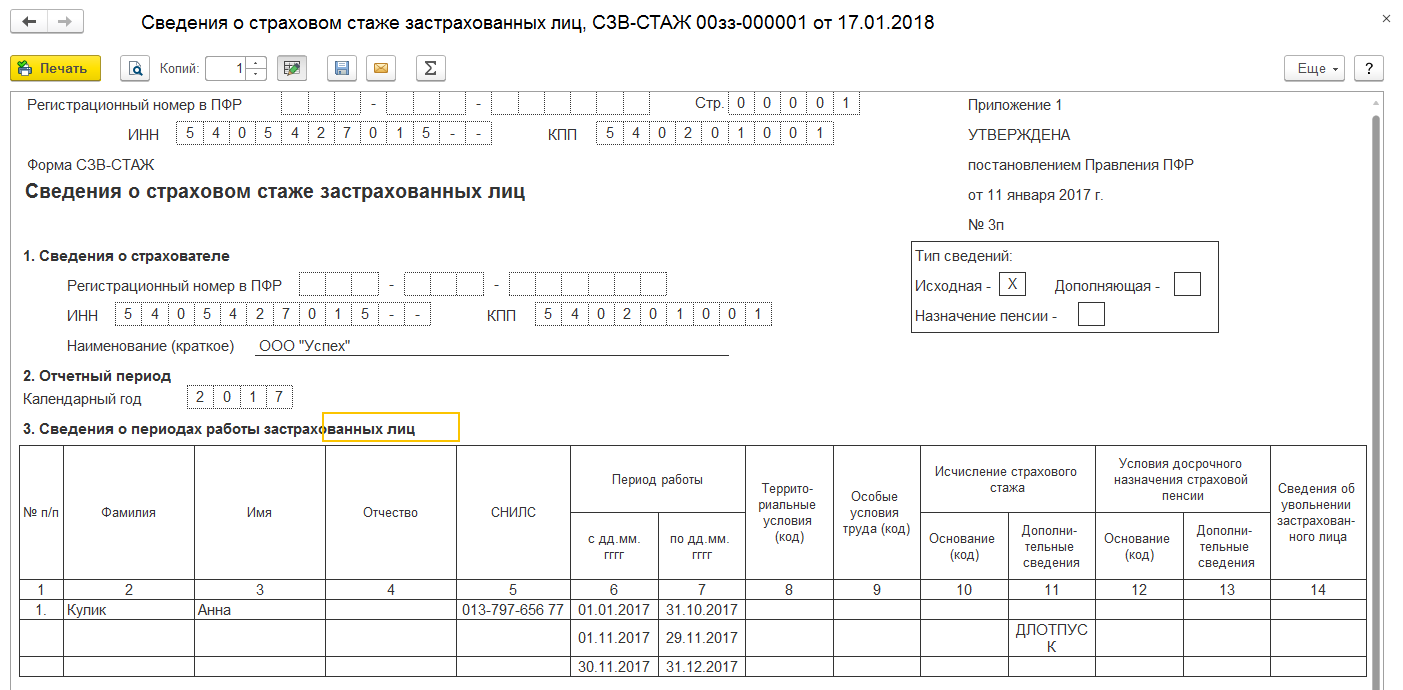

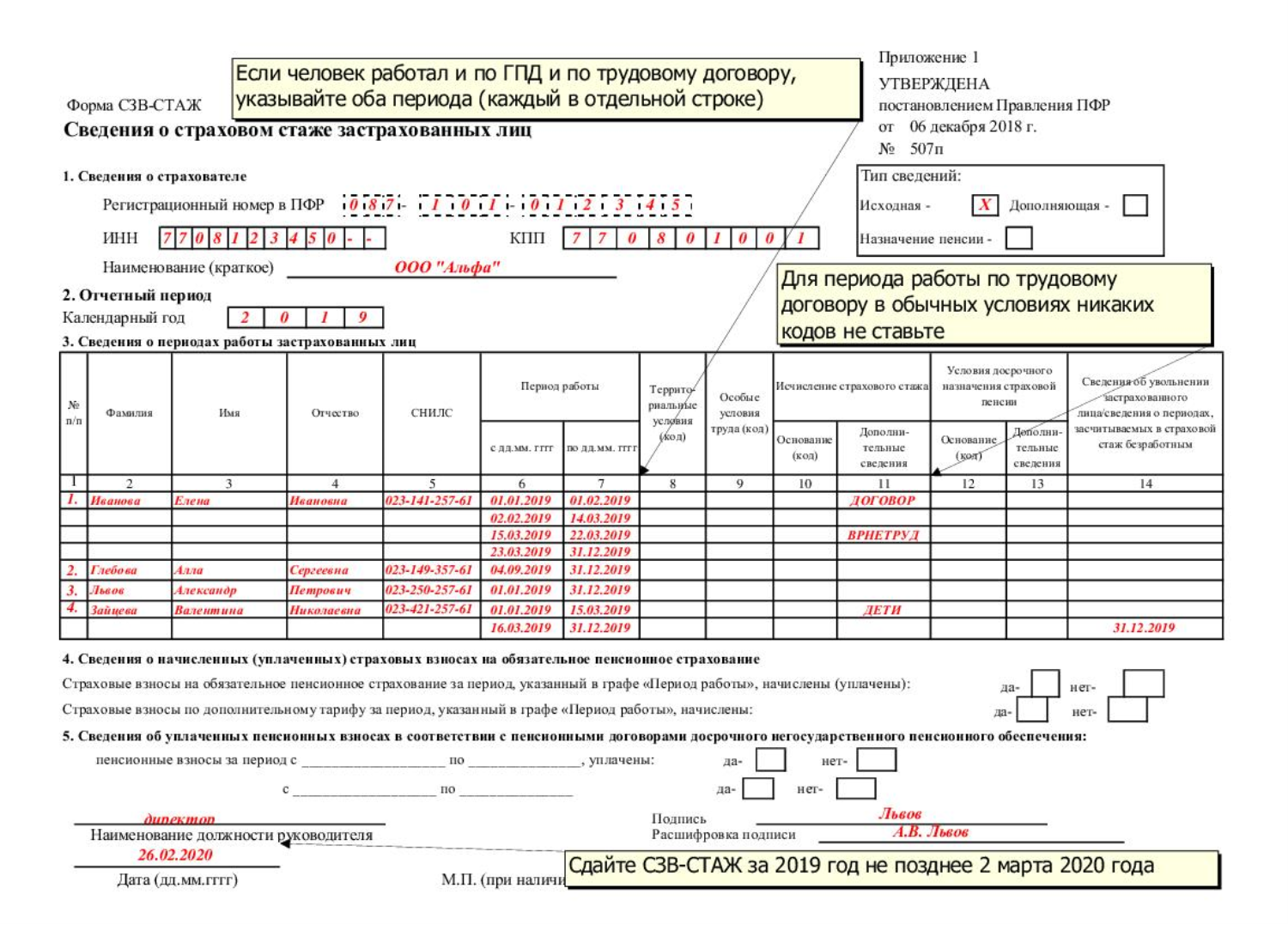

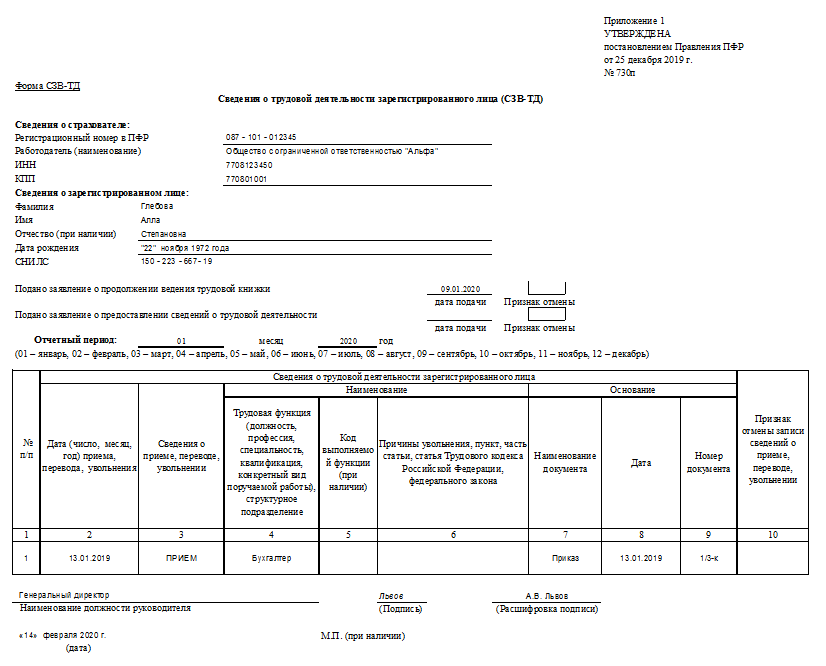

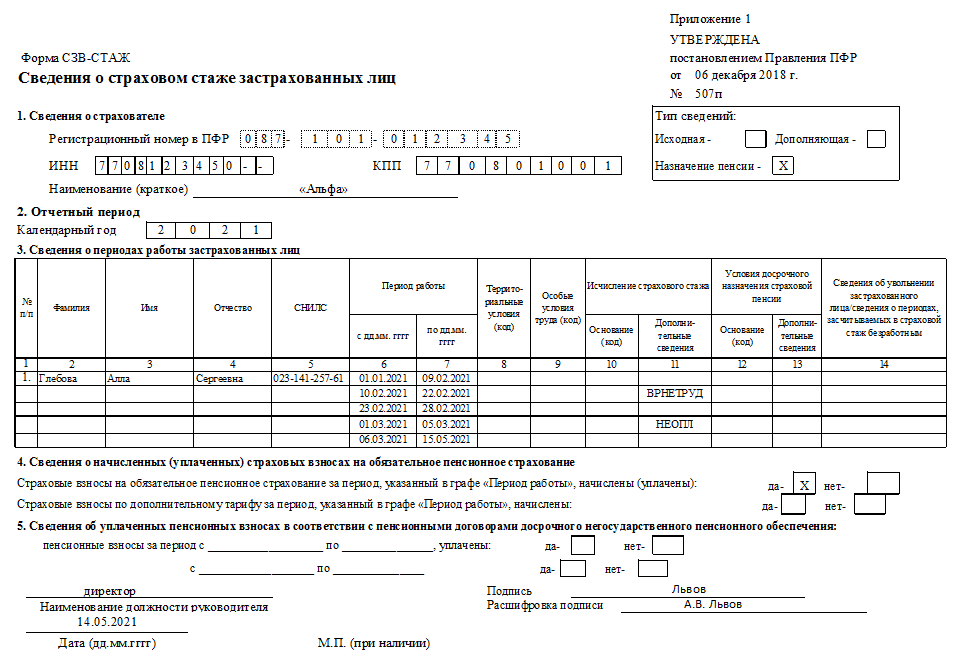

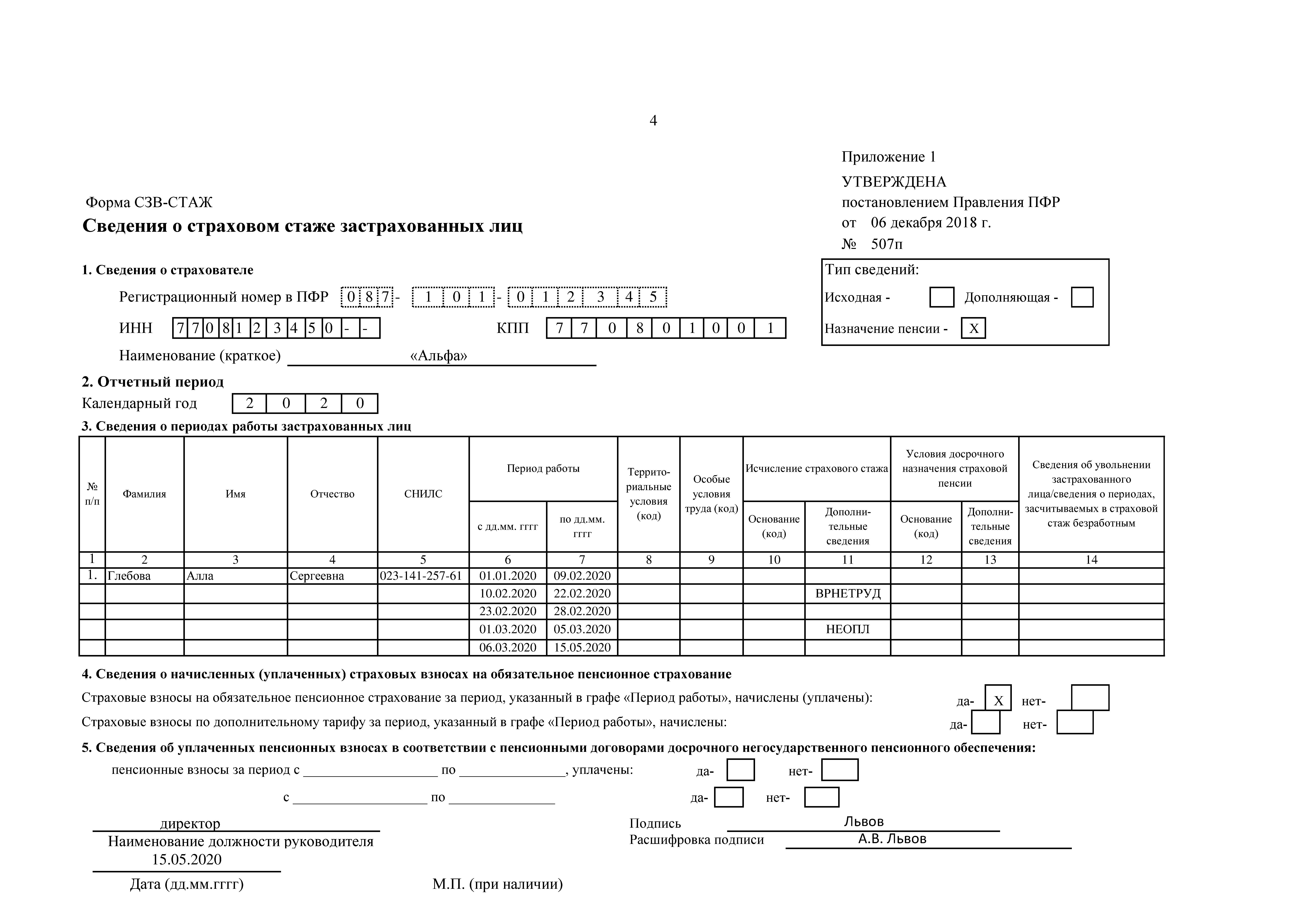

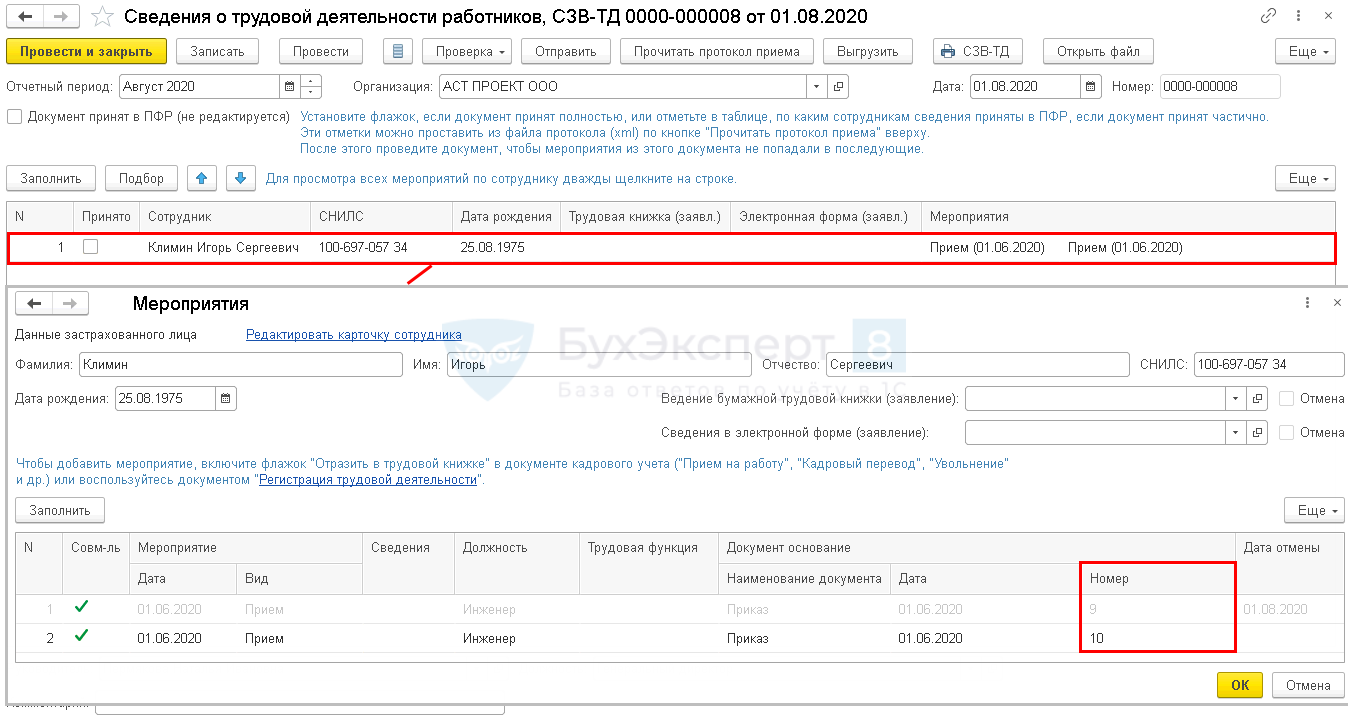

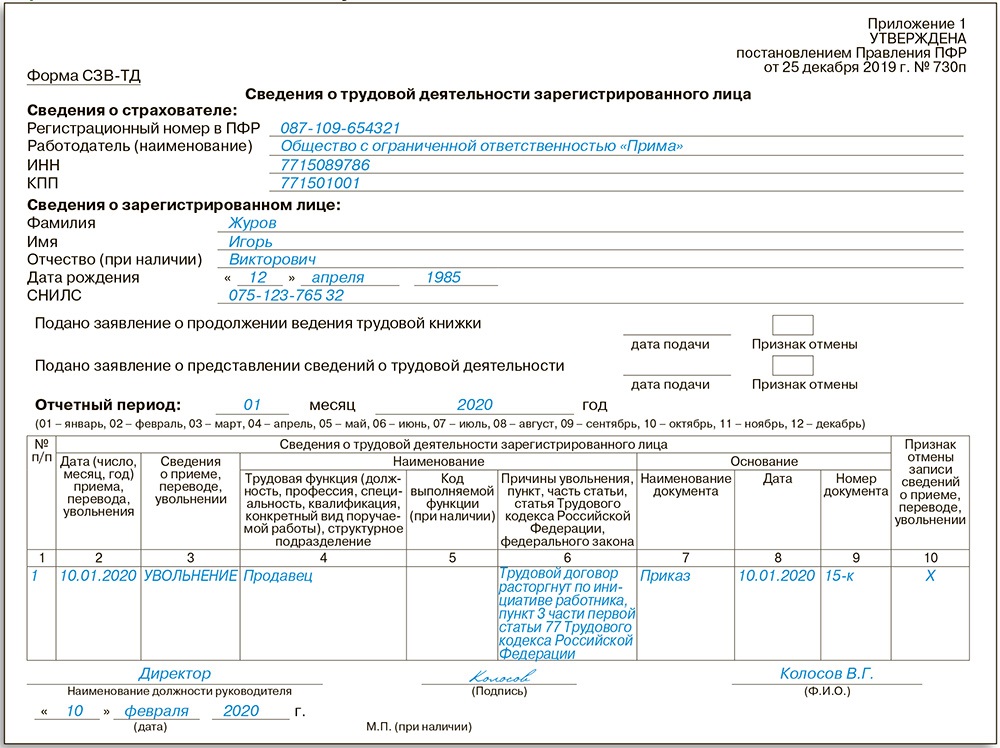

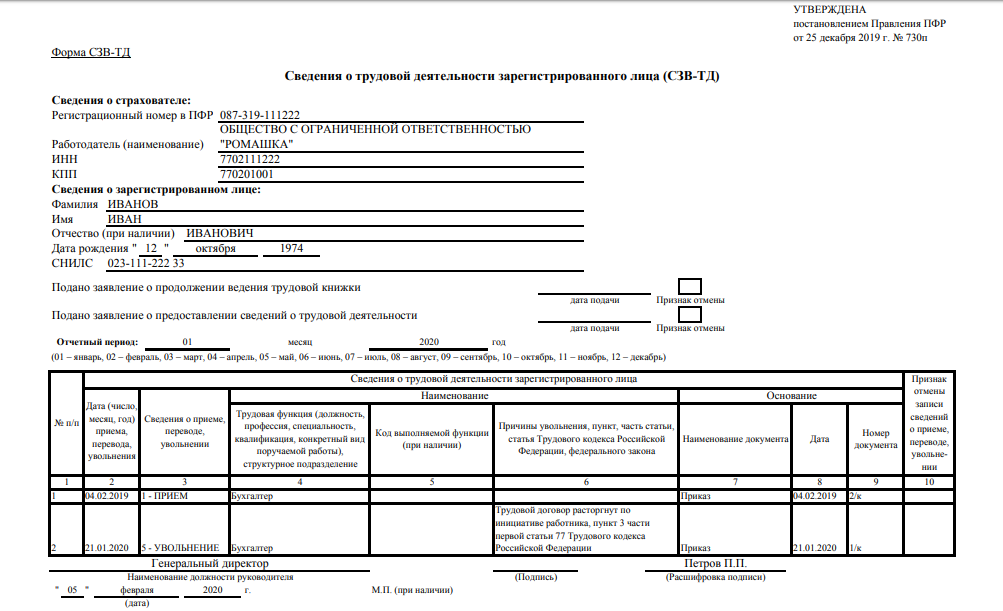

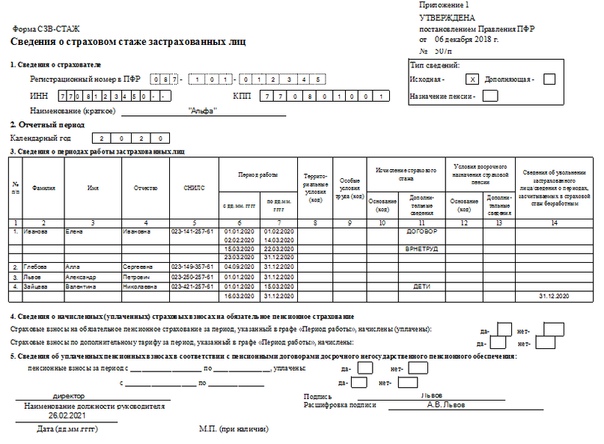

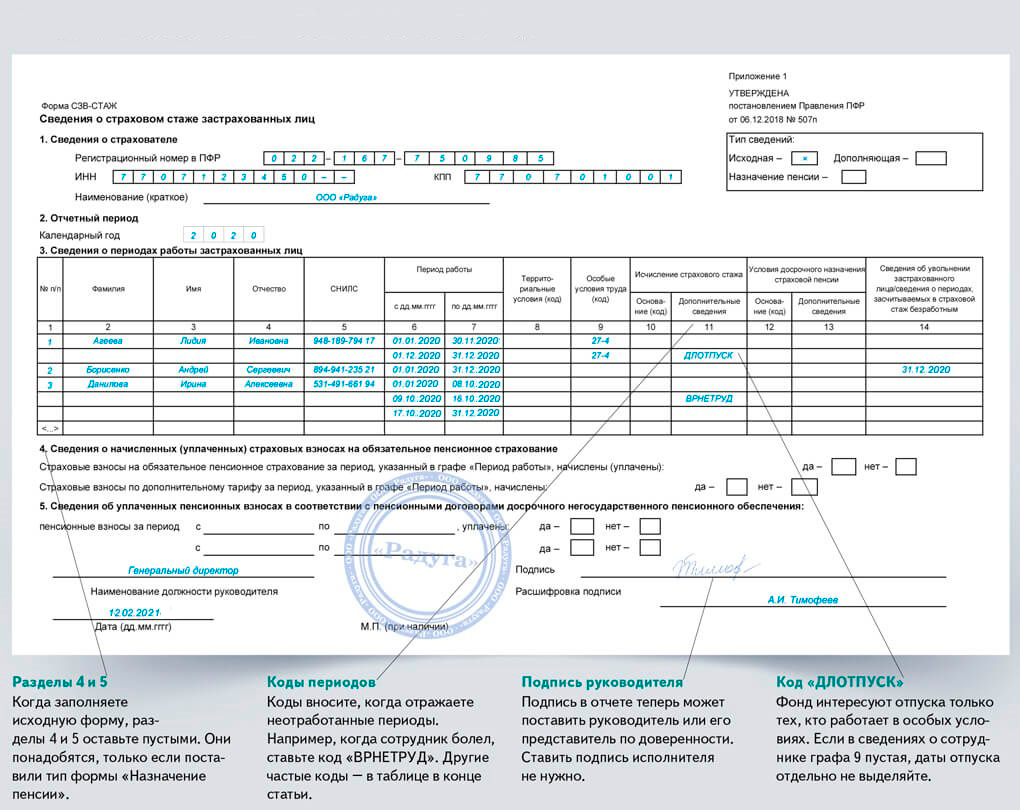

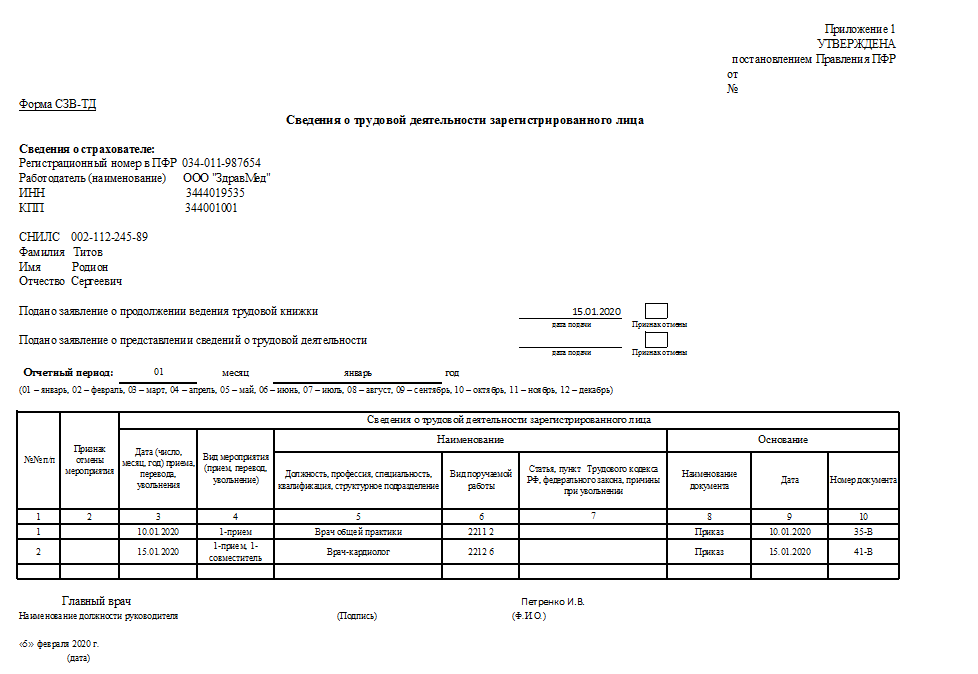

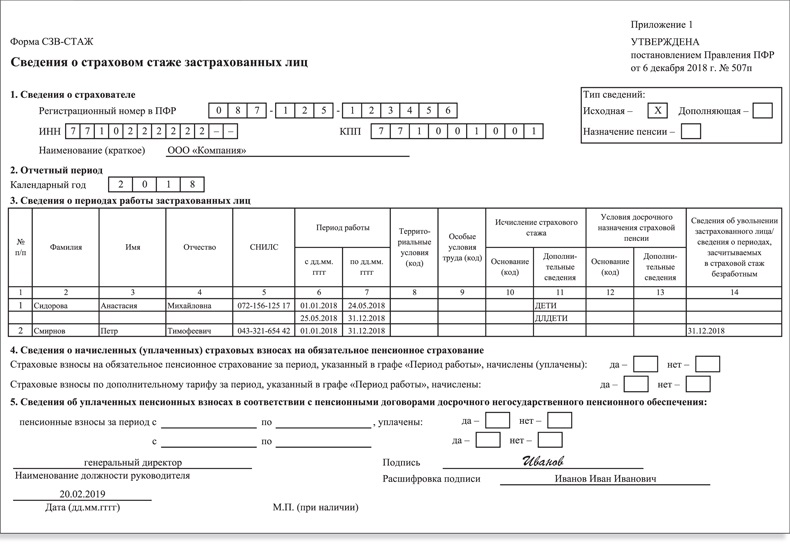

Предлагаем по итогам 2020 года наладить обмен информацией между Росстатом и ФНС России для заполнения формы 12-Ф. - Провести аудит требований по предоставлению форм отчетности по социальным платежам с проработкой вопросов объединения ряда форм (например, объединить отчеты СЗВ-М и СЗВ-ТД, объединить «Расчет по страховым взносам» и СЗВ-СТАЖ). В таком случае для ежемесячной формы статистического наблюдения Форма № П-4 (НЗ) «Сведения о неполной занятости и движении работников» можно будет брать данные из объединенного отчета «Расчет по страховым взносам» и СЗВ-СТАЖ. В форме ФСС-4 упразднить данные, дублирующие сведения расчетов по страховым взносам.

- Объединить ежемесячные, квартальные, полугодовые и годовые статистические отчеты П-4 «Сведения о численности и заработной плате работников» в один ежемесячный, но с разбивкой по ОКПО.

- Рассмотреть возможность упразднения месячного статистического отчета № П-3 «Сведения о финансовом состоянии организации» с получением данных для статистических целей из баз данных ФНС России.

- На законодательном уровне установить обязательность заблаговременной публикации любых изменений в формы и форматы предоставления отчетных данных в адрес госорганов.

- Определить периодичность предоставления отчетности для всех субъектов МСП для любых наблюдений — не чаще 1 раза в квартал.

- Установить единые даты сдачи статистической отчетности вне зависимости от отрасли.

- Установить пятилетний «мораторий» на подачу отчетности ИП и ЮЛ с численностью менее 15 человек в случае, если они участвовали в сплошном наблюдении.

- Запретить органам статистического наблюдения на практике требовать формы налоговой отчетности у субъектов предпринимательства.

- Провести аудит установленных в КОАП размеров штрафов за непредставление первичных статистических данных и иных видов отчетности и проработать вопрос их снижения в проекте нового кодекса по административным правонарушениям.

- Провести анализ возможности интеграции форм статистического наблюдения, в том числе создание единых форм с приведением отраслевых показателей в приложениях к основной форме статистического наблюдения.

Подписывайтесь на канал «Инвест-Форсайта» в «Яндекс.Дзене»

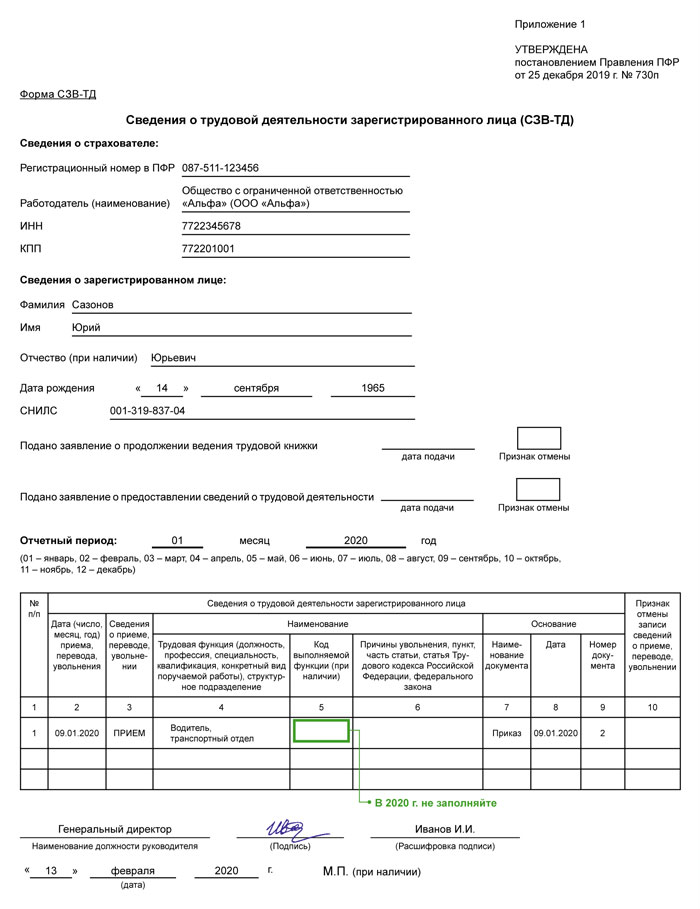

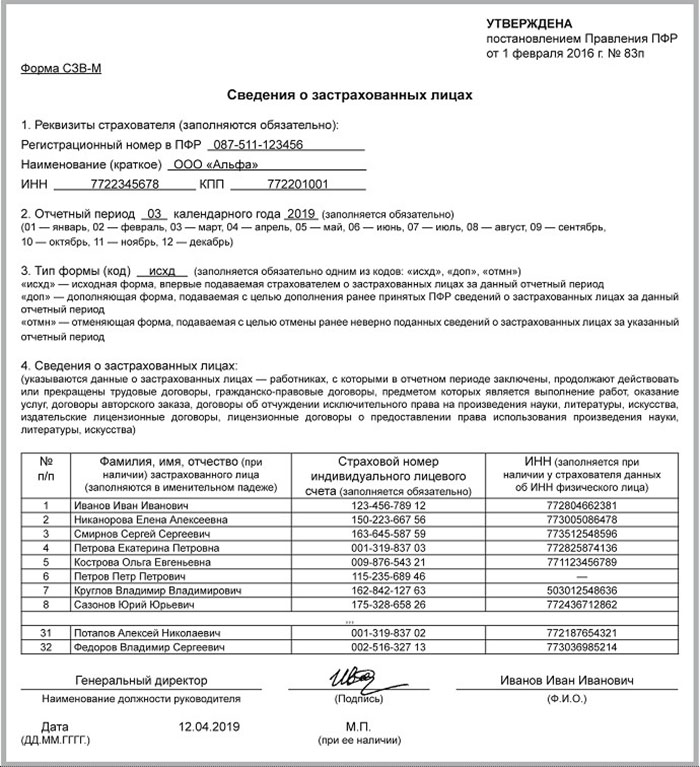

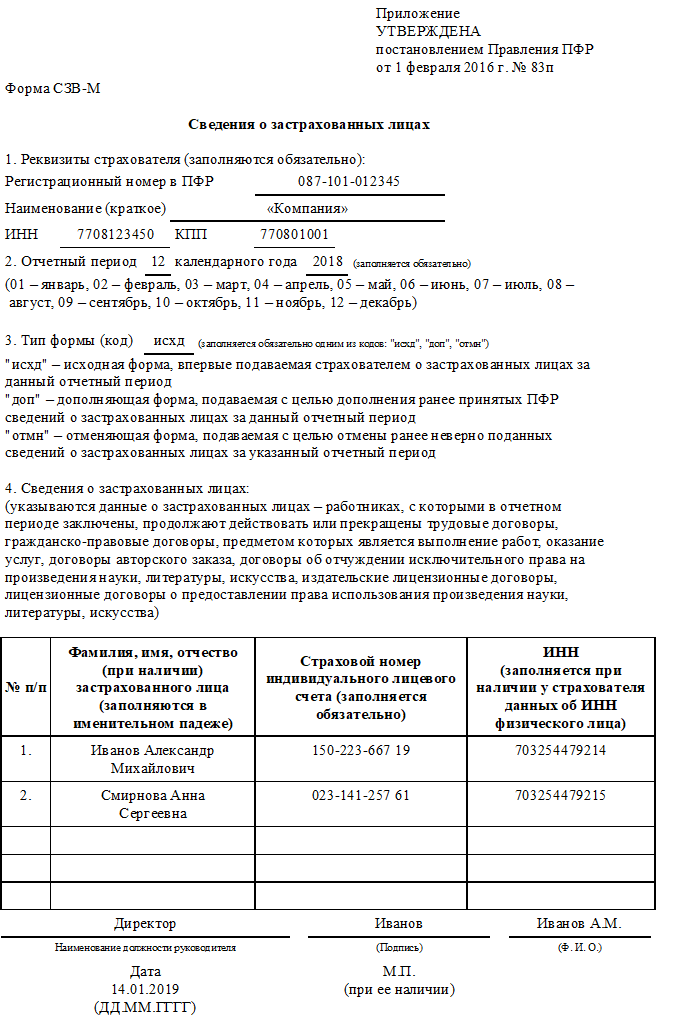

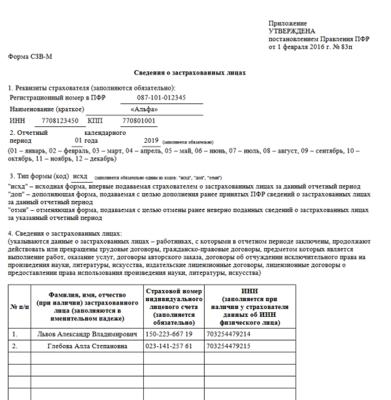

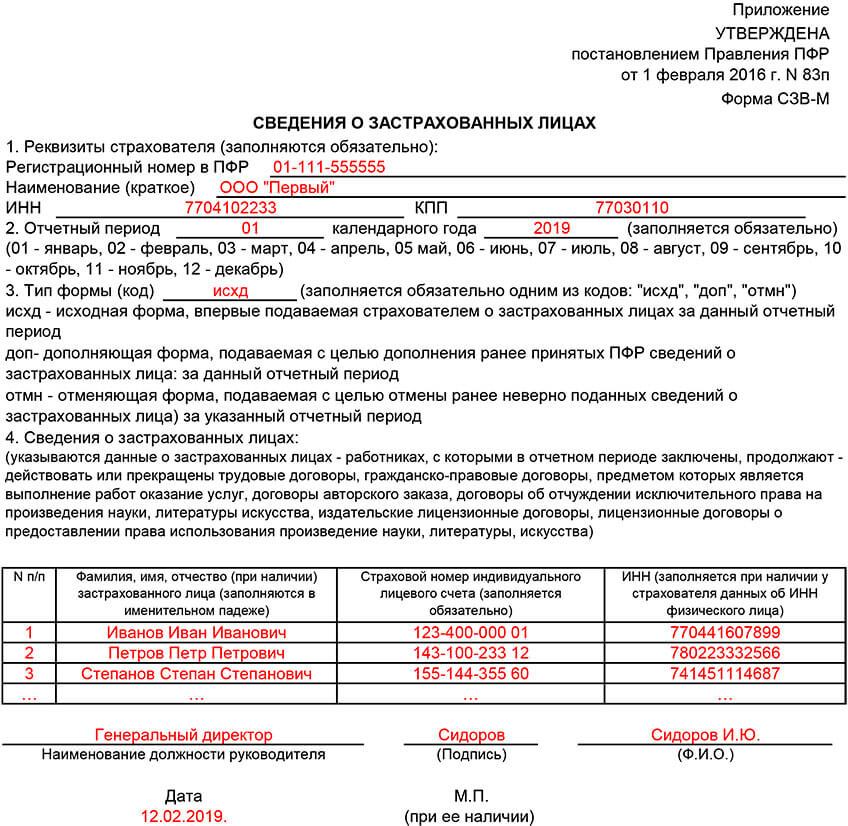

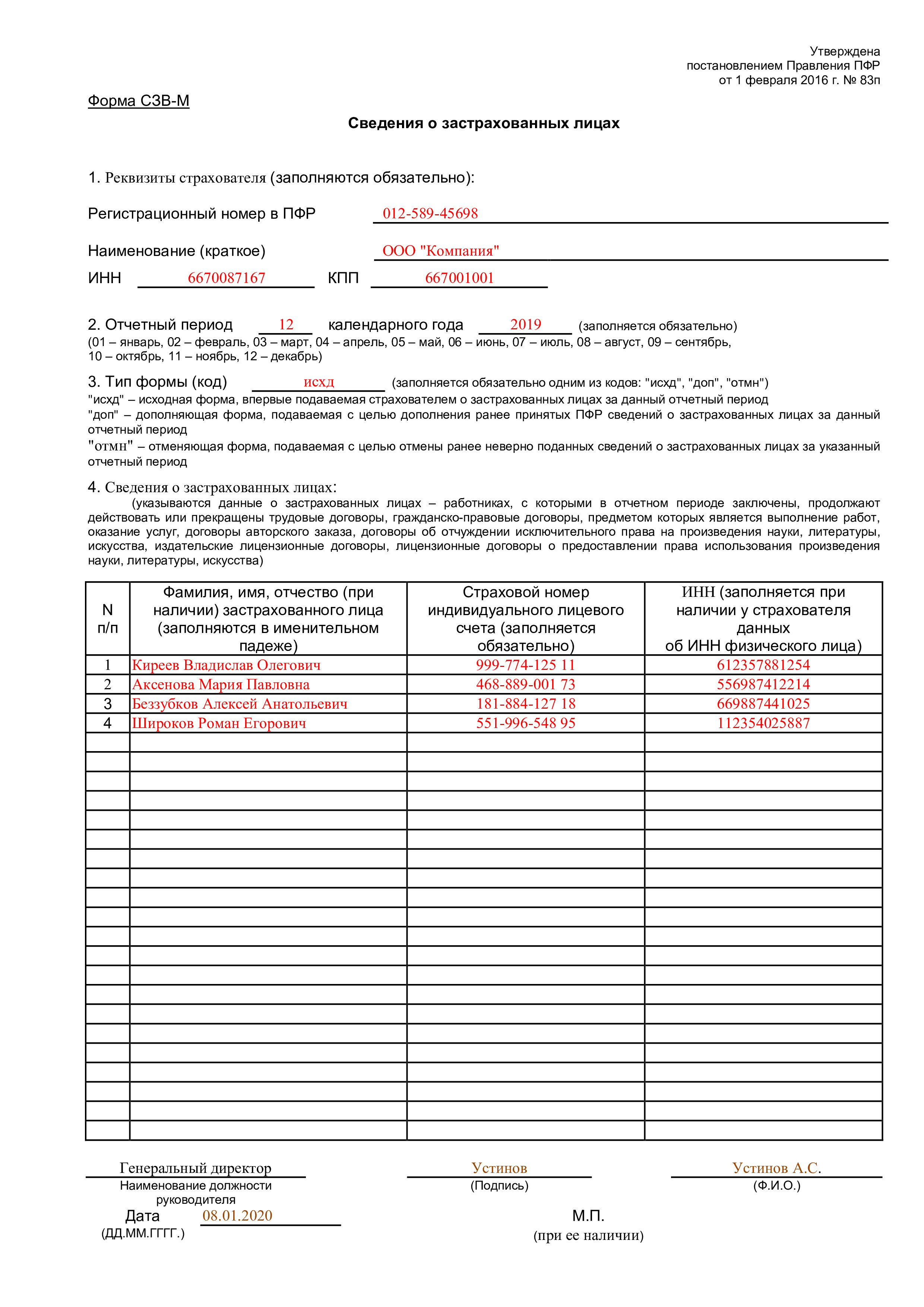

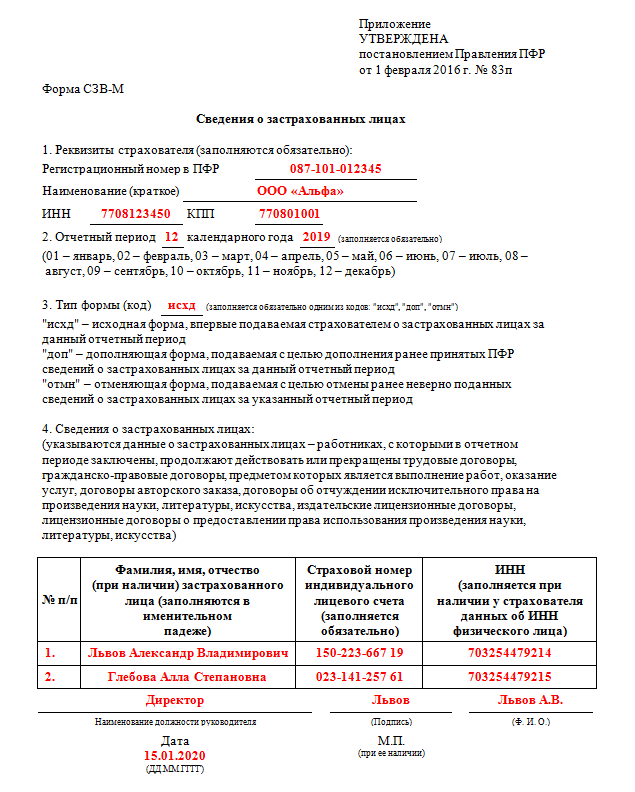

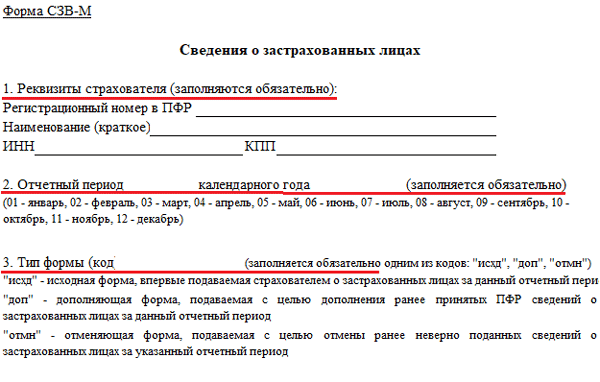

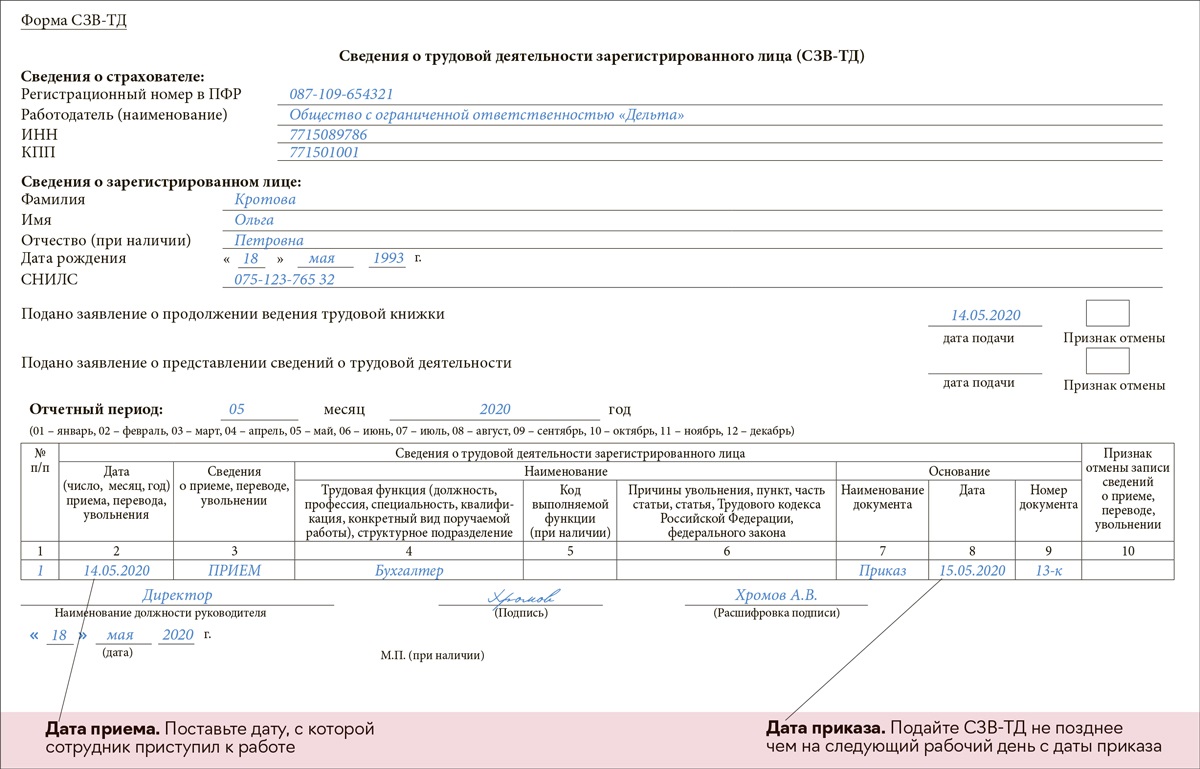

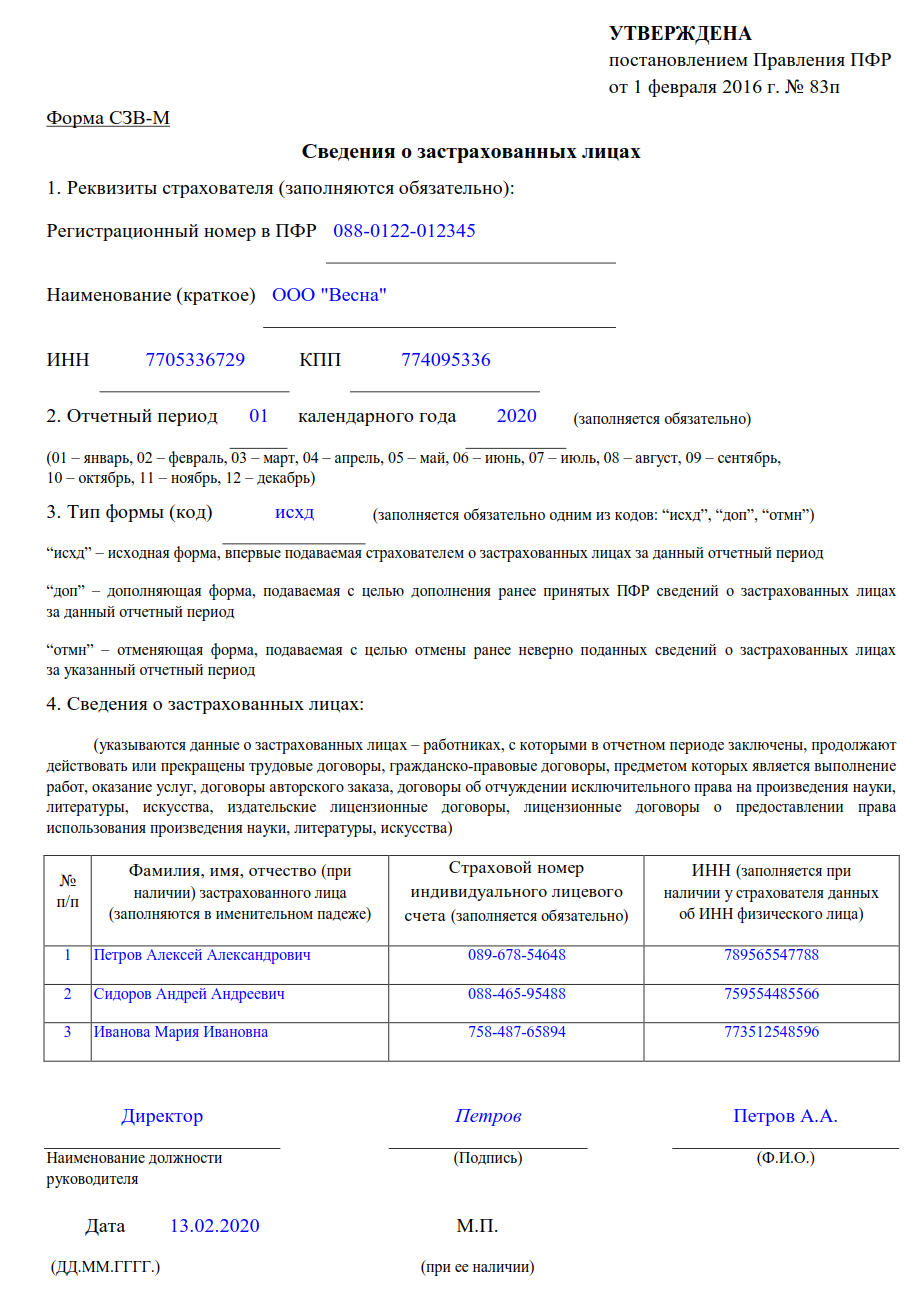

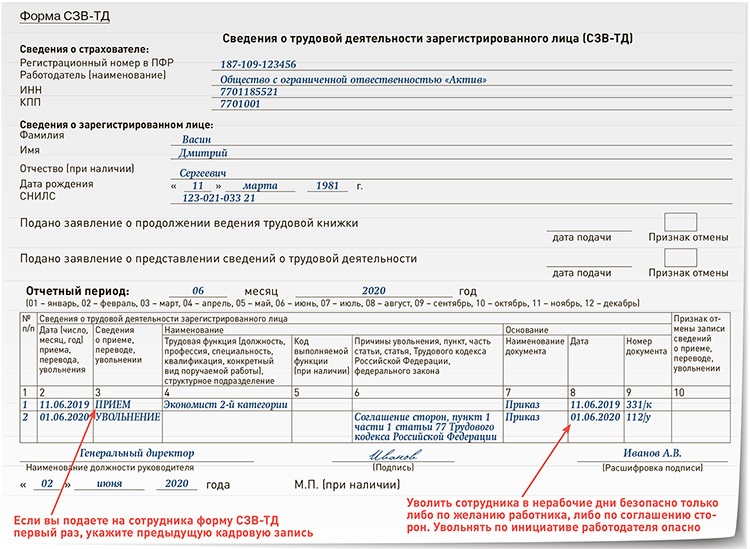

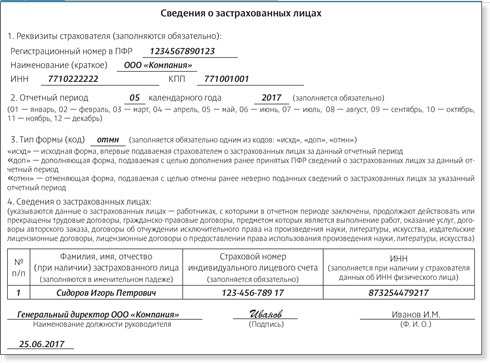

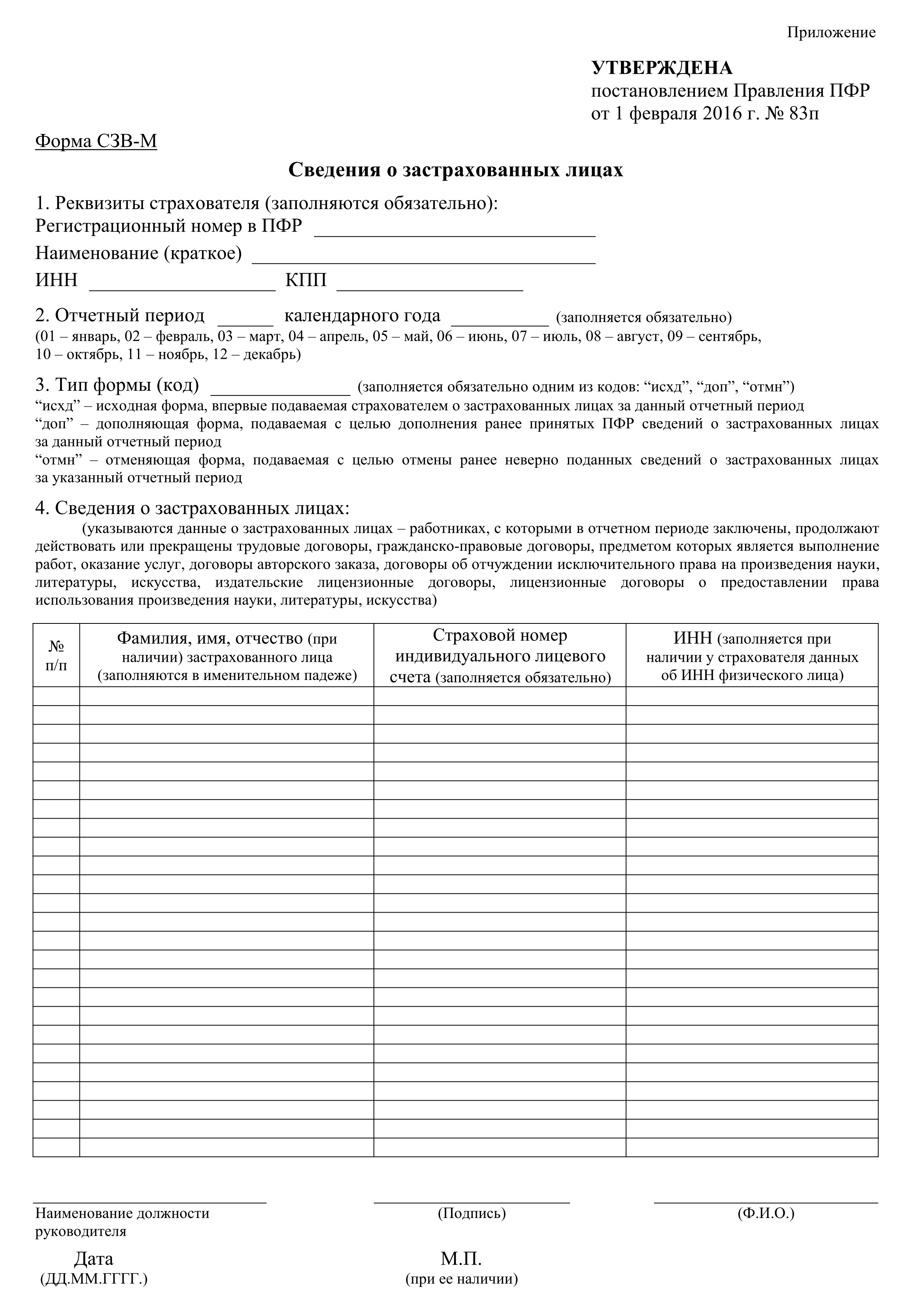

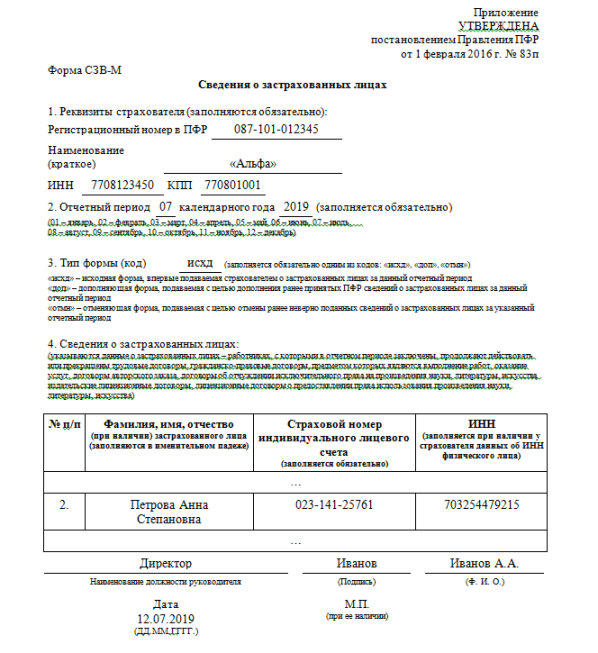

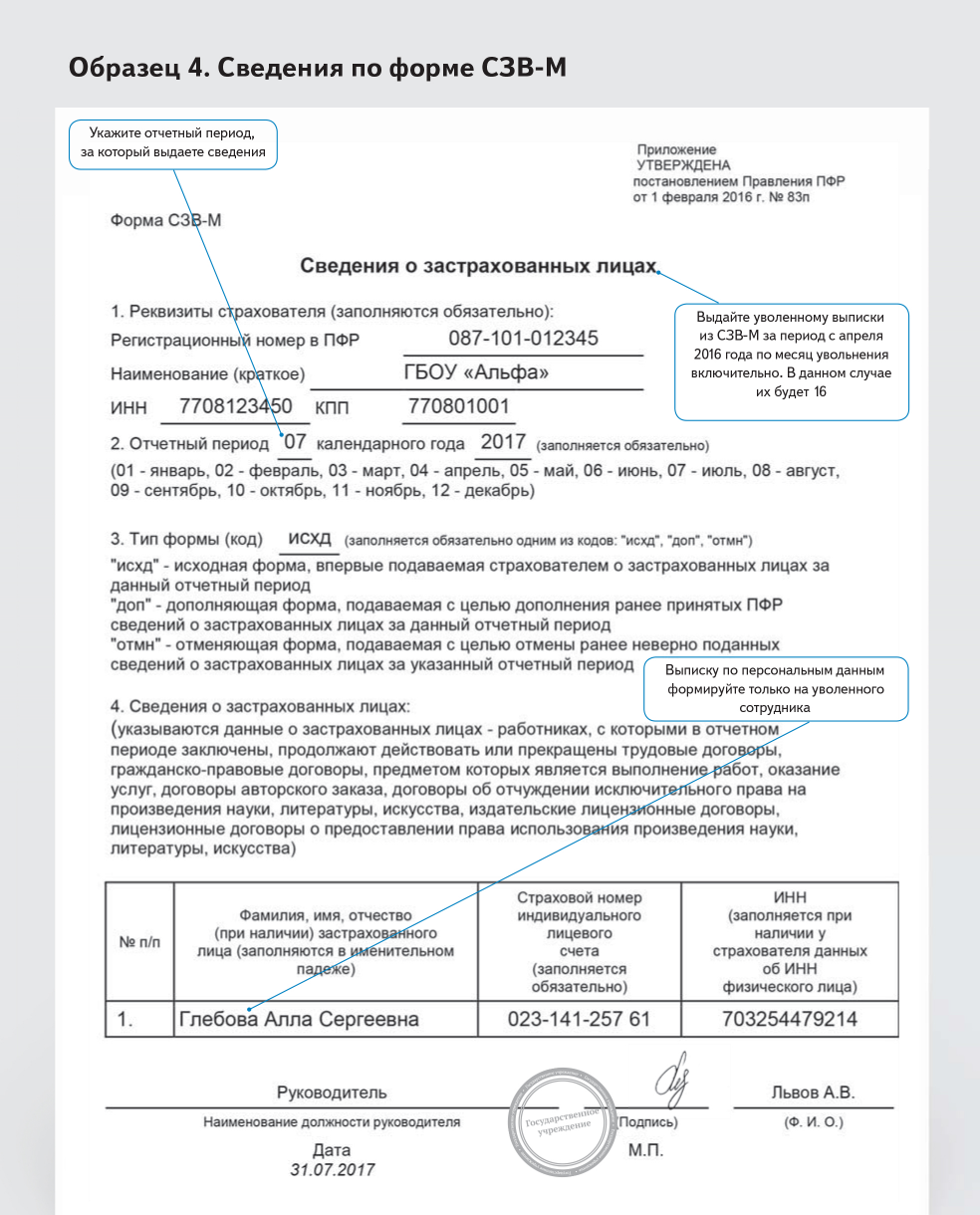

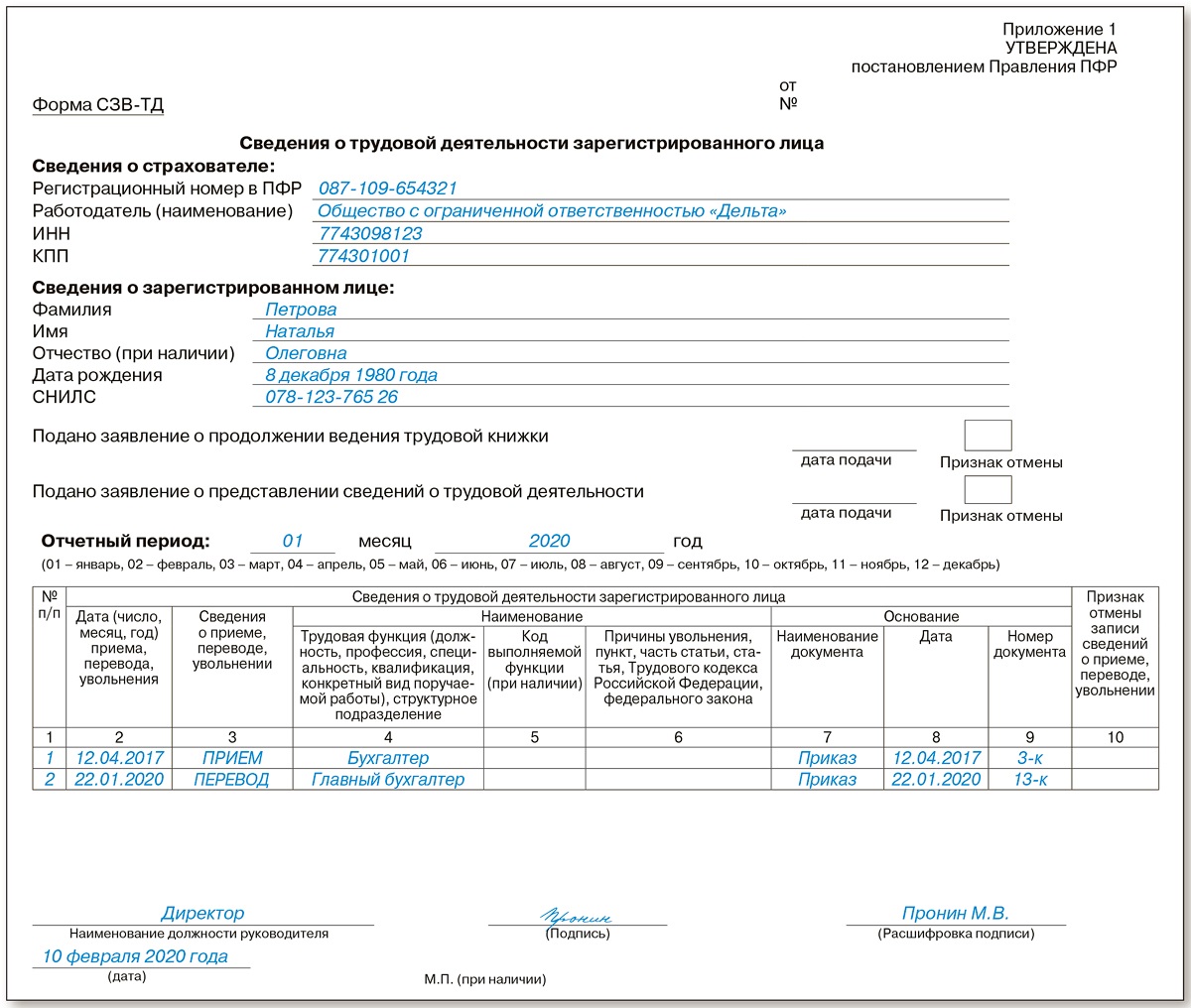

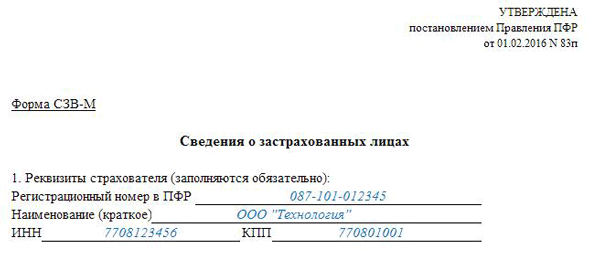

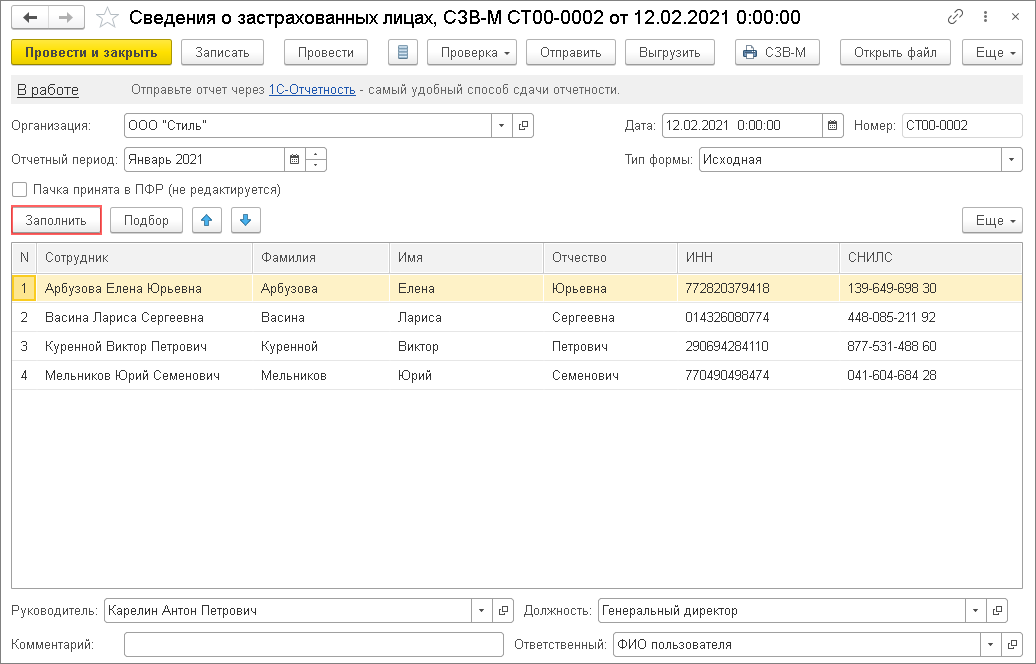

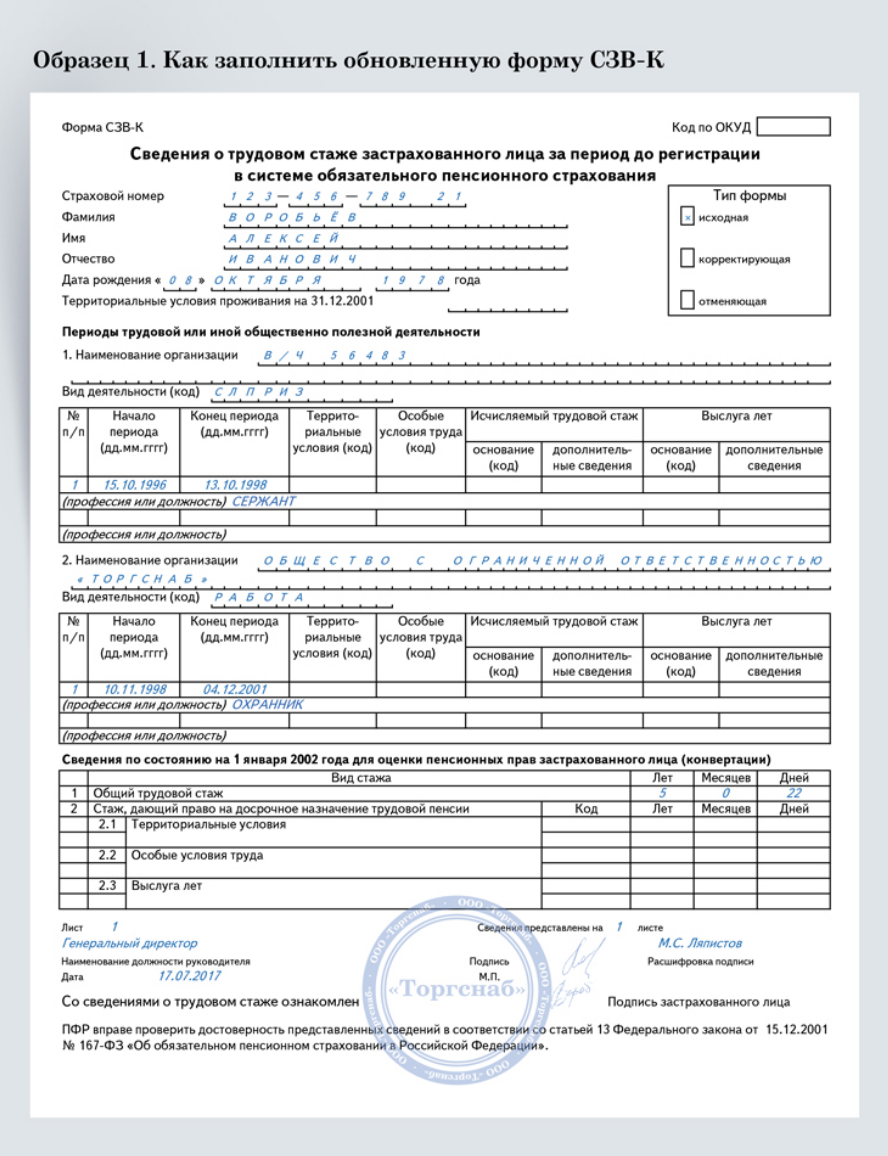

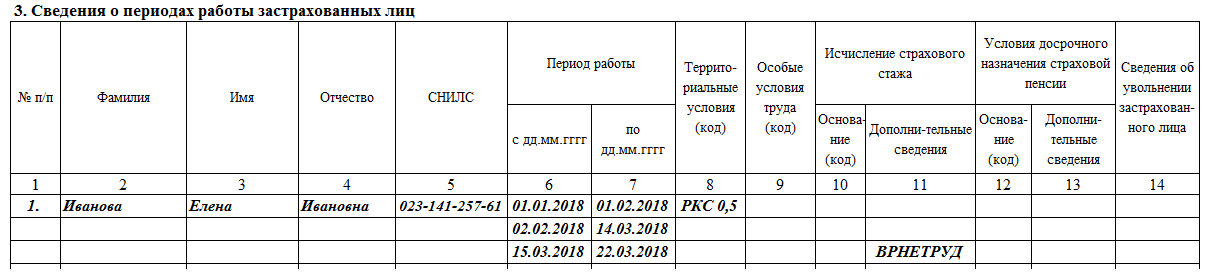

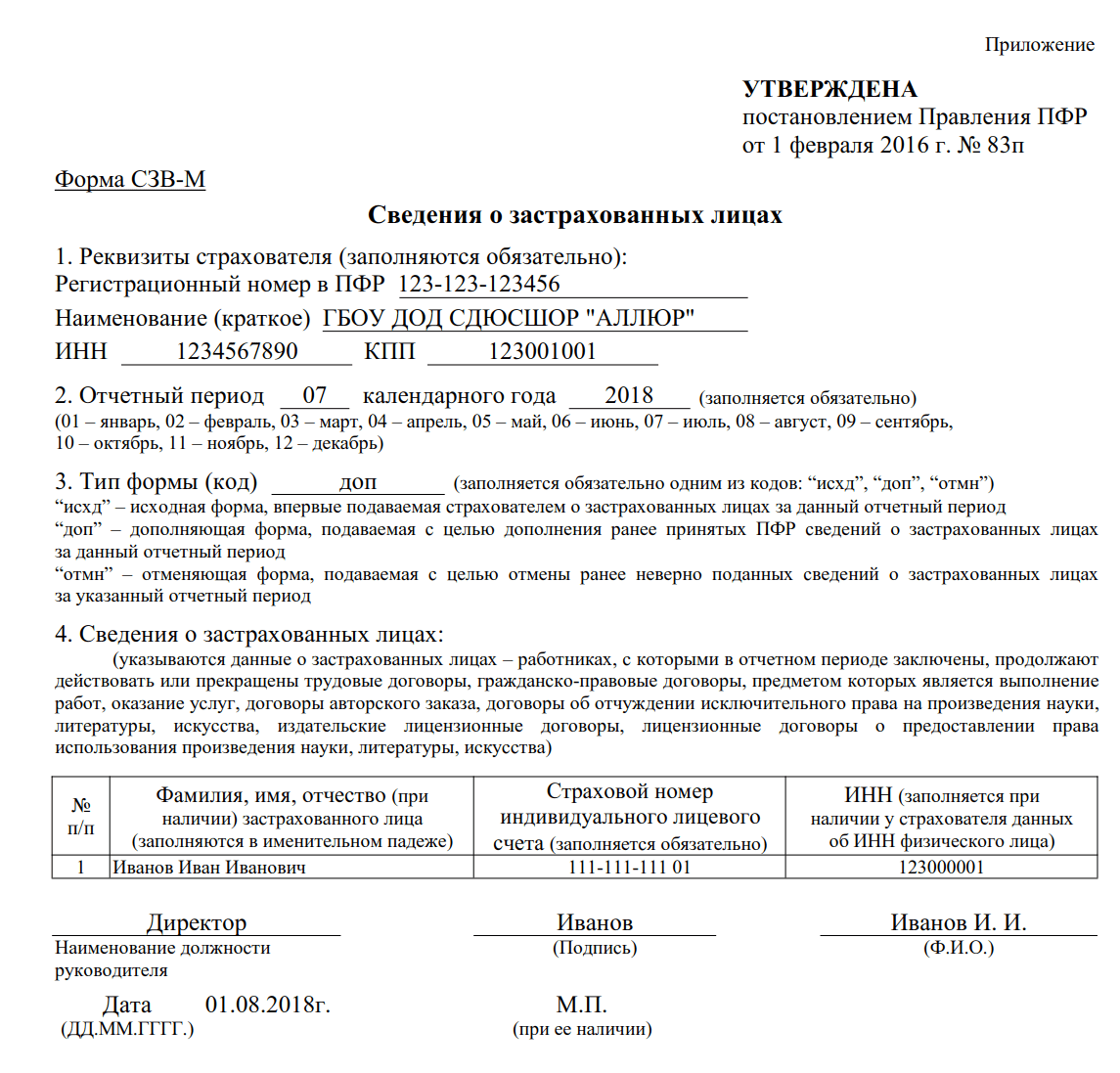

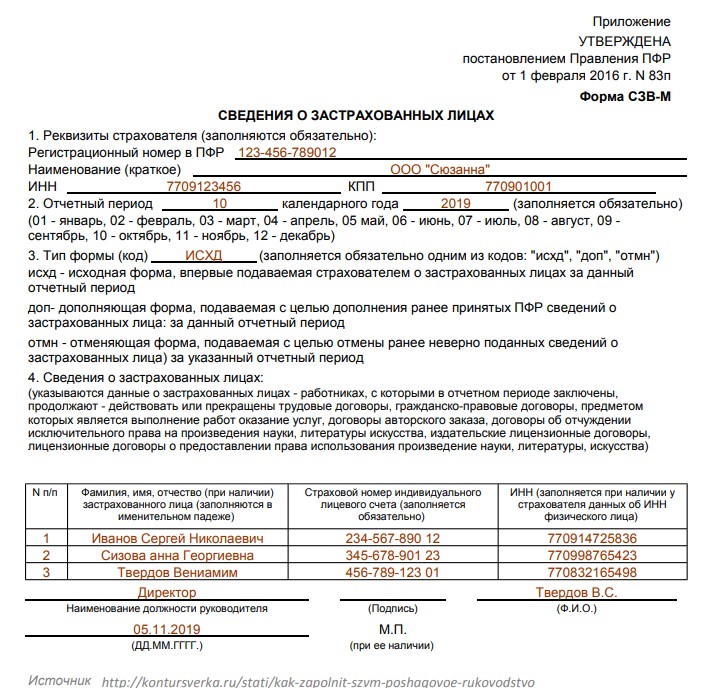

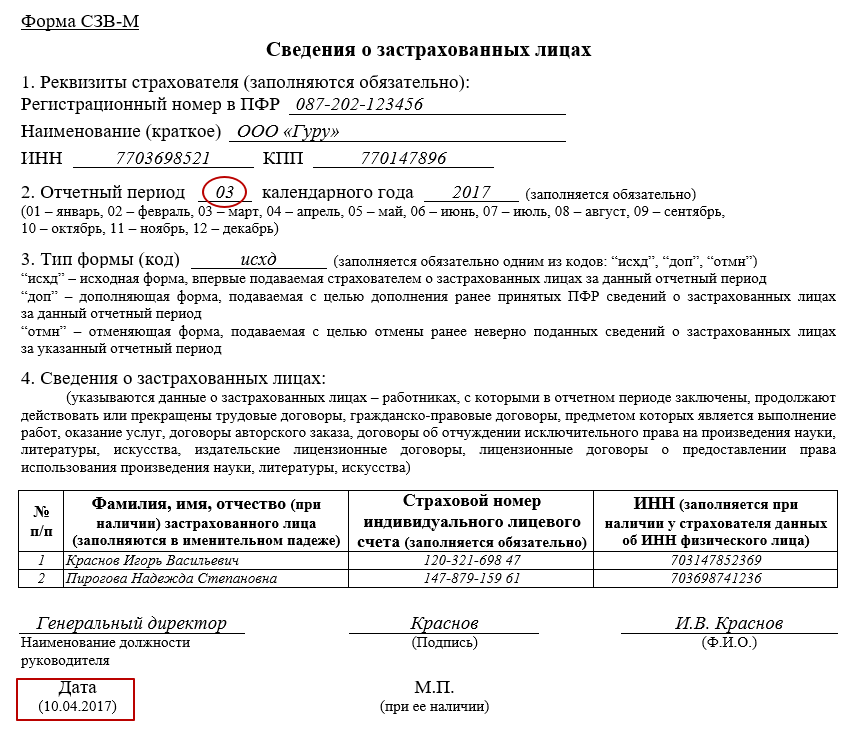

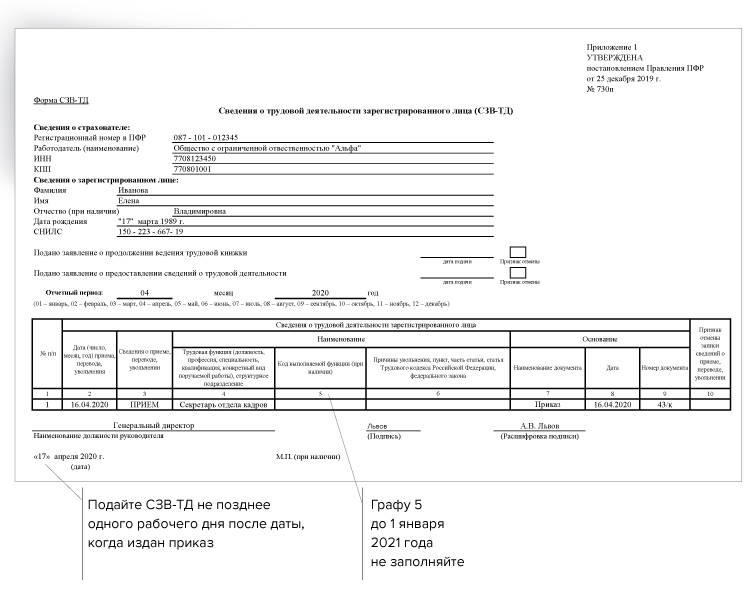

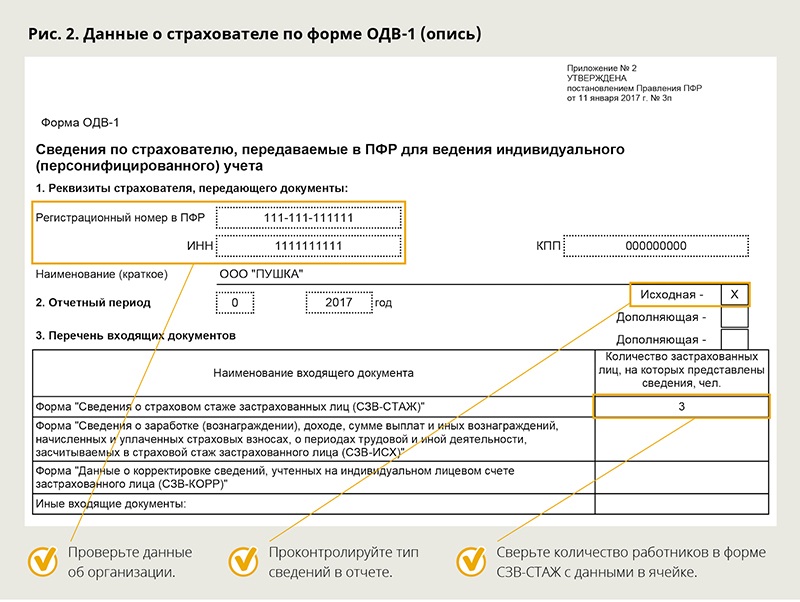

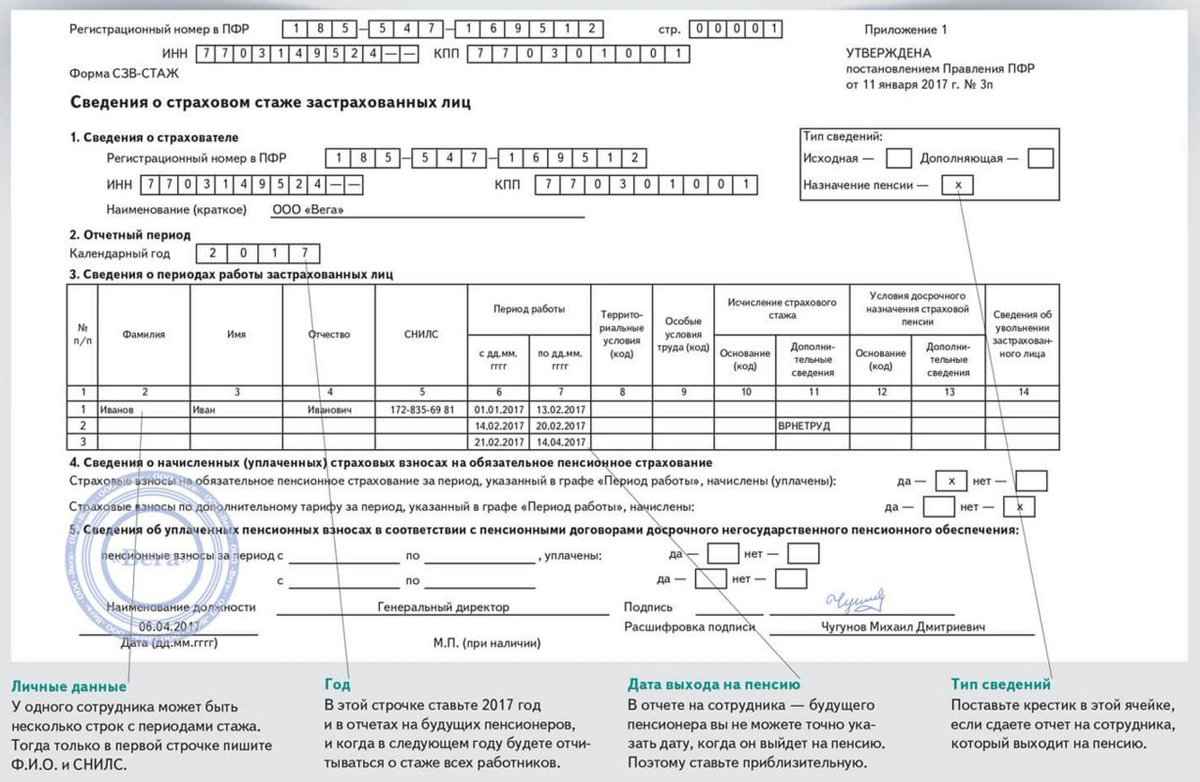

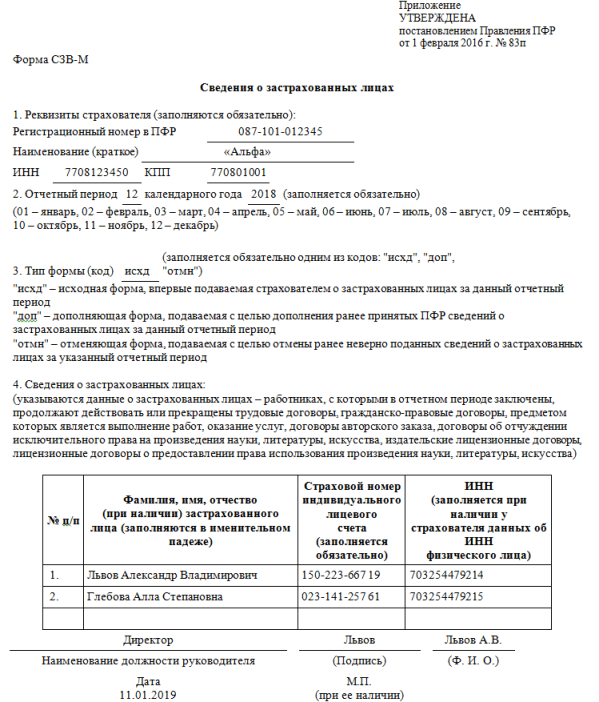

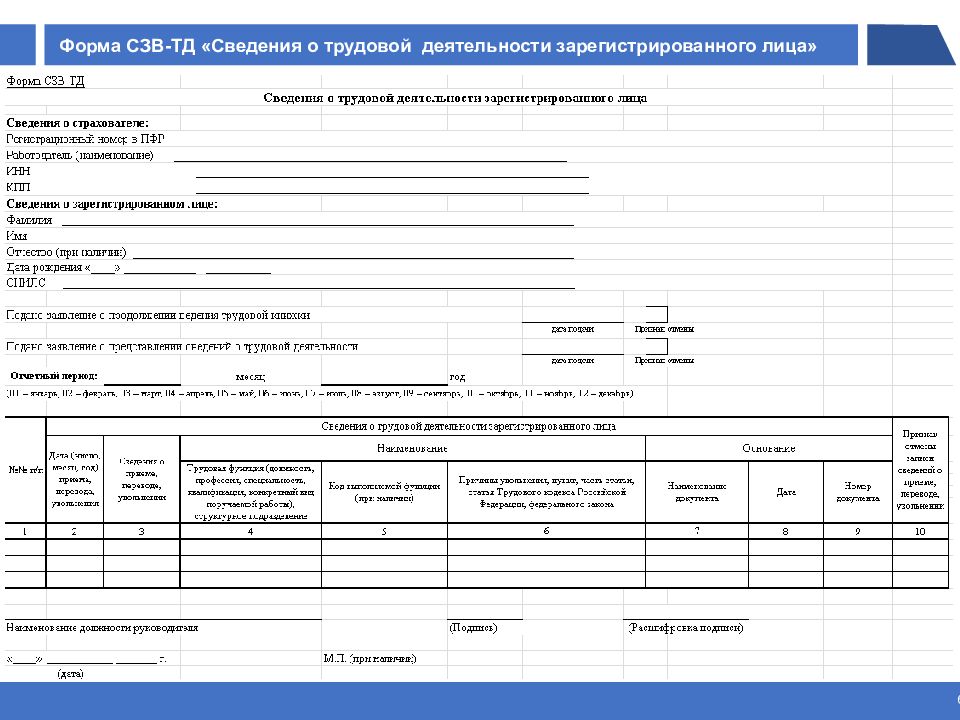

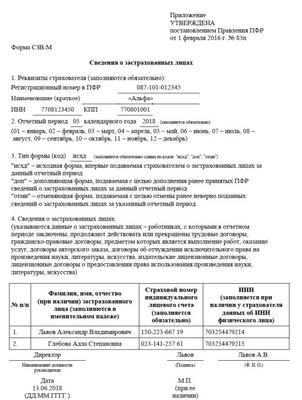

Заполнить сведения о застрахованных лицах

Заполнить сведения о застрахованных лицахВсе организации и индивидуальные предприниматели должны сдавать отчетность в Пенсионный фонд по форме «СЗВ-М». Если численность сотрудников более 25 человек, отчет представляется только в электронном виде.

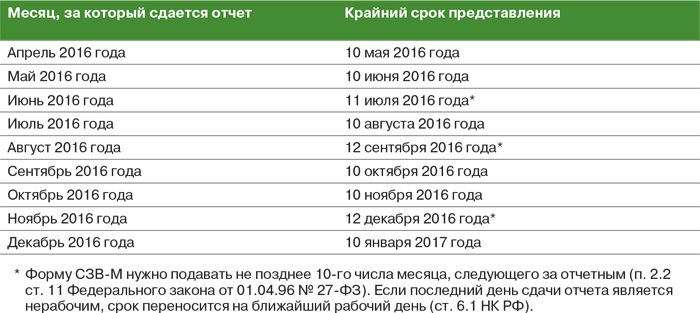

Срок сдачи

Сведения подаются ежемесячно не позднее 15 числа месяца, следующего за отчетным периодом.

Ответственность за несданную отчетность

Как сформировать

- В разделе «Отчетность/Пенсионный» или «Учет/Отчетность/Пенсионный» (в зависимости от конфигурации) создайте отчет «СЗВ-М Сведения о застрахованных лицах».

- Проверьте, правильно ли указан получатель и реквизиты организации.

- Перейдите в раздел «Сотрудники», нажмите «+ Сотрудник» и добавьте работников.

- Заполните СНИЛС и ИНН сотрудников.

- Проверьте отчет и отправьте его в ПФ.

Отчет будет принят, когда пенсионный фонд пришлет положительный протокол.

Лицензия

Любой тариф сервиса «Отчетность через интернет».

- В разделе «ПФР» создайте новый отчет и выберите форму «СЗВ-М Сведения о застрахованных лицах».

- Проверьте отчетный период, представителя в ПФР и нажмите «Далее».

- На вкладке «Отредактировать отчет» нажмите «Сведения о застрахованных лицах».

- В открывшемся окне кликните «Добавить» и выберите сотрудников.

- Проверьте СНИЛС и ИНН работников. Если они не указаны, выделите строку с ФИО сотрудника, нажмите «Изменить» и заполните сведения.

- Когда все сведения будут заполнены, проверьте и отправьте отчет.

Отчет будет принят, когда пенсионный фонд пришлет положительный протокол.

Лицензия

Любой тариф сервиса «Отчетность через интернет».

- В разделе «Пенсионный» создайте отчет и выберите форму «СЗВ-М Сведения о застрахованных лицах».

- Нажмите «Сведения о застрахованных лицах».

- В открывшемся окне кликните «Добавить» и выберите сотрудников.

- Убедитесь, что у каждого работника указаны СНИЛС и ИНН работников. Если нет, откройте сведения о сотруднике и заполните их.

- В разделе «Реквизиты» проверьте данные организации, получателя и подписанта.

- Когда все сведения будут заполнены, проверьте и отправьте отчет.

Отчет будет принят, когда пенсионный фонд пришлет положительный протокол.

Лицензия

Любой тариф сервиса «Отчетность через интернет».

Как сдать отчет по форме СЗВ-М?

Получать статьи на почту

Подключите сервис 1С-Отчетность бесплатно на 30 дней!

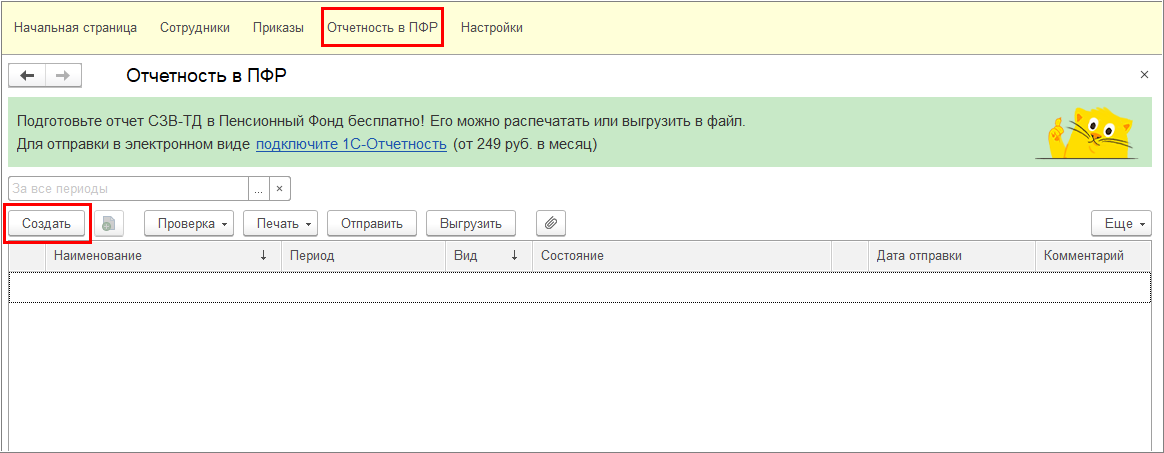

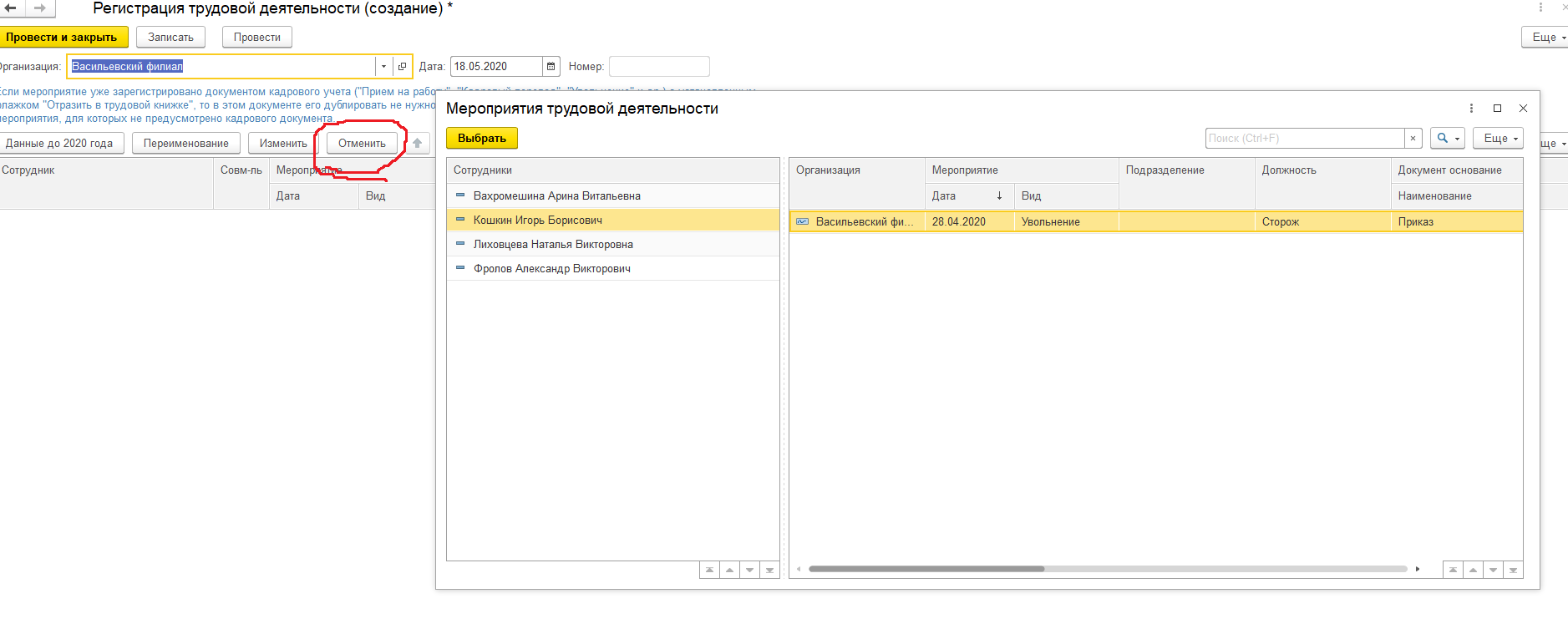

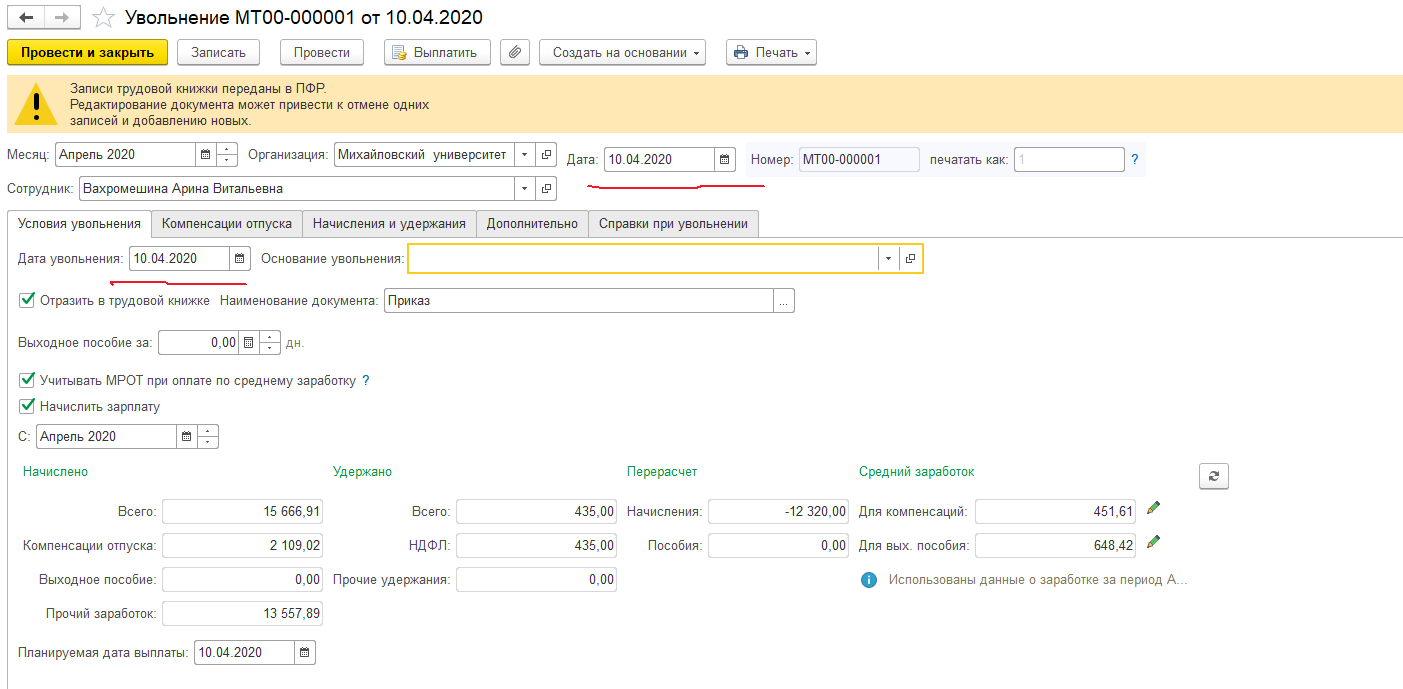

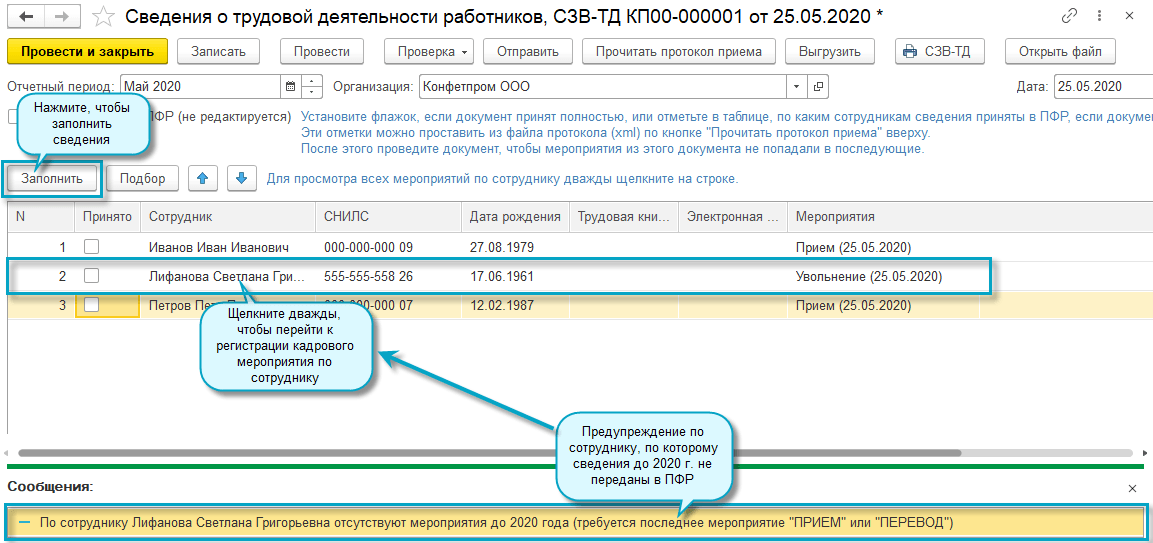

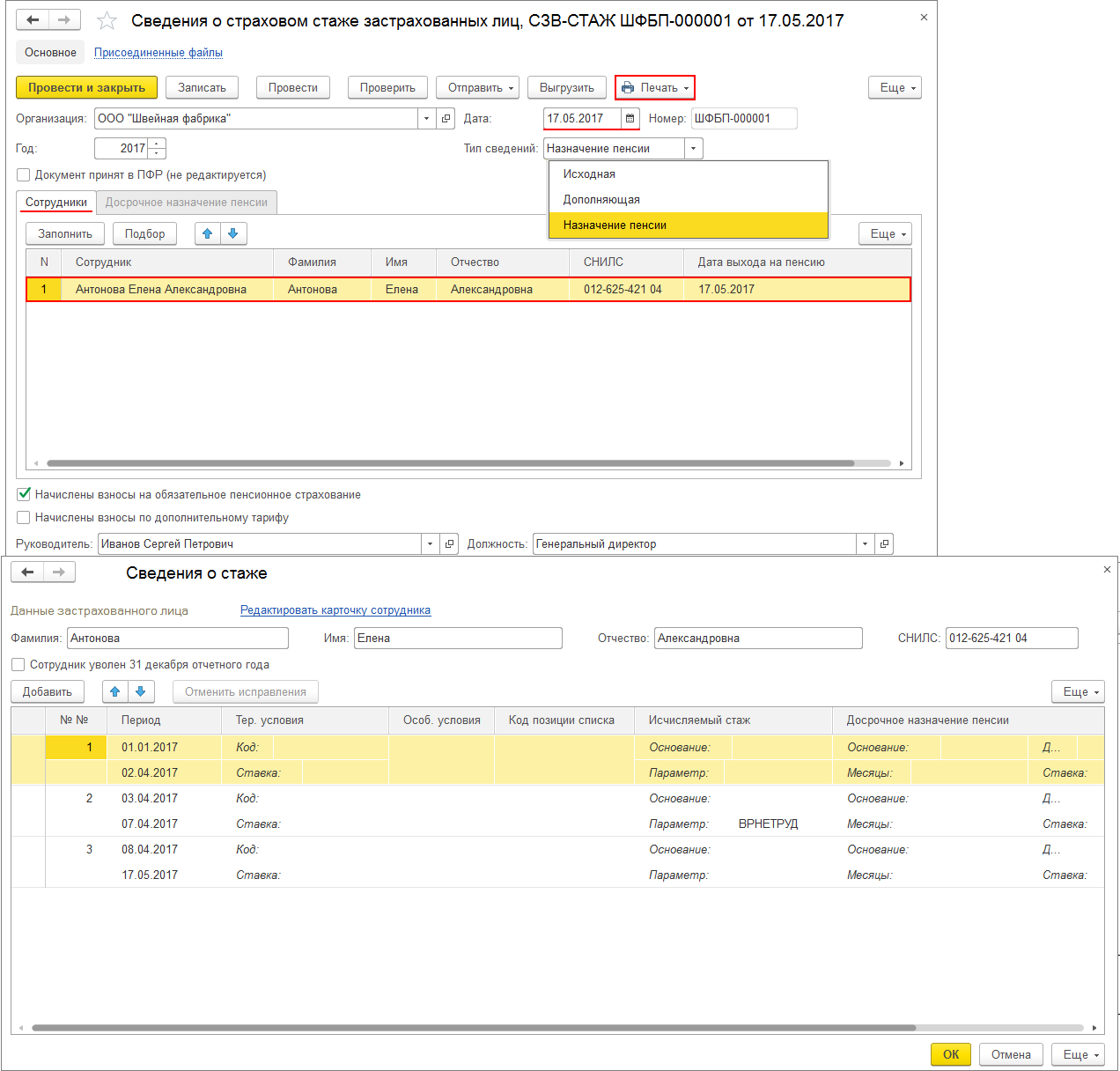

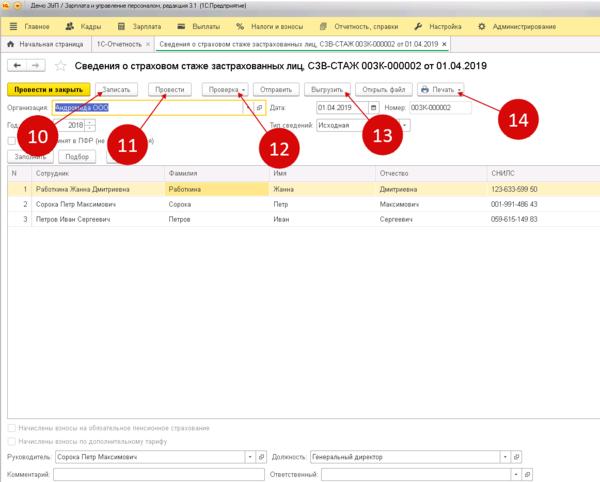

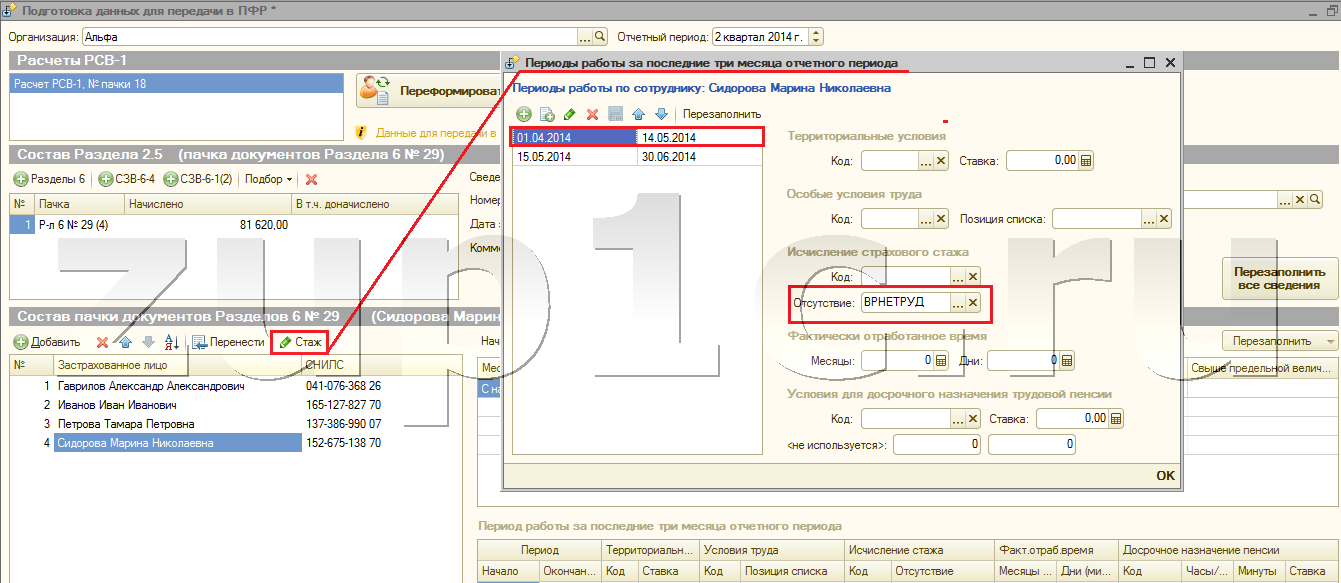

Шаг 1. Открытие раздела Документы персучета

В программе 1С заходим во вкладку Отчетность, справки и выбираем Документы персучета.

Рис. 1. Вкладка Отчетность, справки в 1С: ЗУП ред. 3.1

Шаг 2. Создание отчета по форме СЗВ-М

В отрывшемся разделе Документы персучета нажимаем на кнопку Создать и выбираем Сведения о застрахованных лицах, СЗВ-М.

Рис. 2. Раздел Документы персучета

Шаг 3. Заполнение отчета по форме СЗВ-М

В отчете выбираем отчетный период и тип формы «Исходная». Нажимаем кнопку Заполнить.

Рис. 3. Заполнение отчета о застрахованных лицах

Шаг 4. Проверка корректности заполнения отчета

Сервис позволяет запустить программу, проверяющую корректность заполнения отчета.

На кнопке Отправить нажмите на стрелку вниз и выберите Проверить в Интернете.

Рис. 4. Проверка корректности заполнения отчета

В открывшемся окне заполните согласие на передачу персональных данных и нажмите Продолжить.

Рис. 5. Форма согласия на передачу персональных данных

По итогам проверки отчета программа выдаст сообщение. Если ошибок в отчете не обнаружено, переходите к следующему шагу.

Рис. 6. Сообщение об отсутствии ошибок в отчете

Шаг 5. Отправка отчета в Пенсионный фонд РФ

На кнопке Отправить нажмите на стрелку вниз и выберите Отправить в ПФР.

Рис. 7. Отправка отчета в ПФР

Подтвердите, что отчет заполнен полностью и корректно, нажмите отправить.

Рис. 8. Подтверждение отправки отчета

Далее вы увидите сообщение о том, что отчет успешно отправлен в ПФР.

Рис. 9. Сообщение о сдаче отчета

Шаг 6. Проверка отправки отчета

Для того чтобы проверить отправку отчета в разделе Отчетность, справки, зайдите в раздел 1С-Отчетность.

Рис. 10. Вкладка Отчетность, справки в 1С: ЗУП ред. 3.1

В разделе Отчеты можно увидеть отправленные в контролирующие органы документы и их статус. Отчет по форме СЗВ-М сразу после отправки будет иметь статус Отправлено в ПФР.

Рис. 11. Вкладка Отчеты в разделе 1С-Отчетность

После обновления информации с контролирующими органами статус отчета должен измениться на Отчет успешно сдан.

С сервисом 1С-Отчетность сдать отчет просто и удобно. Вы можете оформить у нас бесплатный доступ на месяц к сервису, для того чтобы попробовать в работе все преимущества.

Подключите сервис бесплатно на 30 дней!

Ответы на часто возникающие вопросы

Когда сдавать отчет

Отчет о застрахованных лицах необходимо сдавать до 15-го числа месяца, следующего за отчетным.

Кому нужно сдавать отчет

Всем организациям и ИП, имеющим в найме сотрудников по трудовому и гражданско-правовому договору, необходимо подавать в ПФР сведения о застрахованных лицах.

В отчет должны включаться сотрудники в декрете, отпуске и уволившиеся в рамках отчетного периода.

Можно ли сдавать отчет досрочно

Отчет можно сдать с 1-го числа месяца, следующего за отчетным.

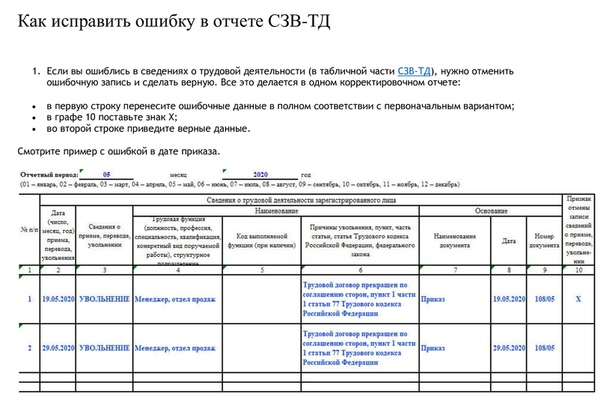

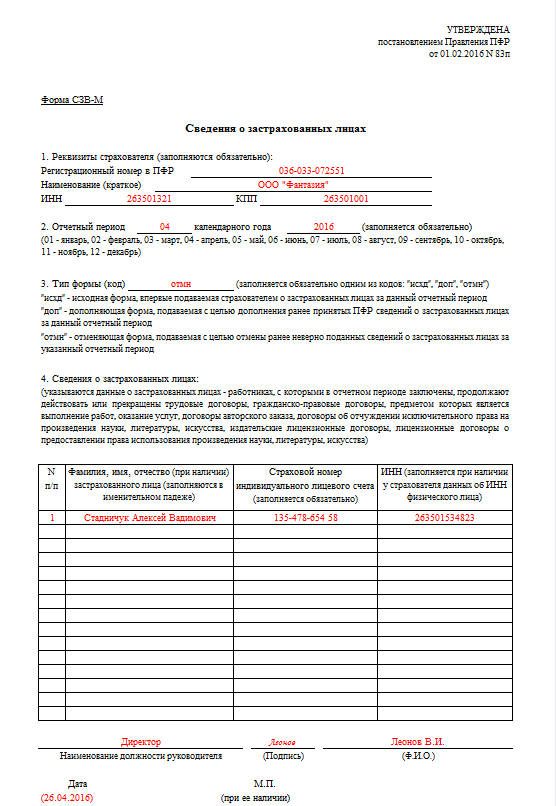

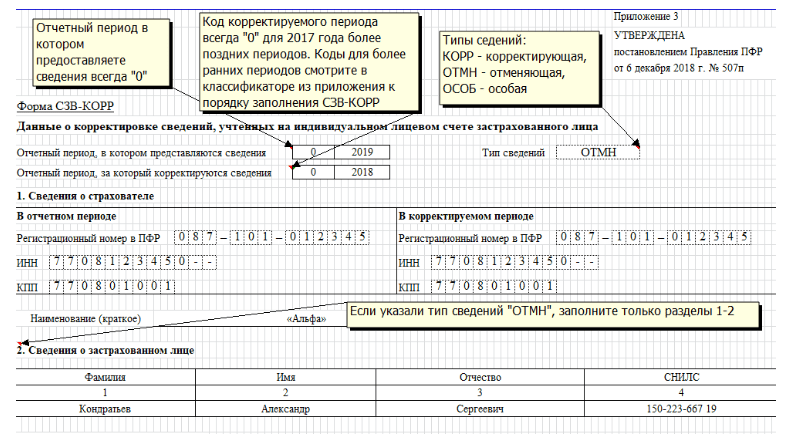

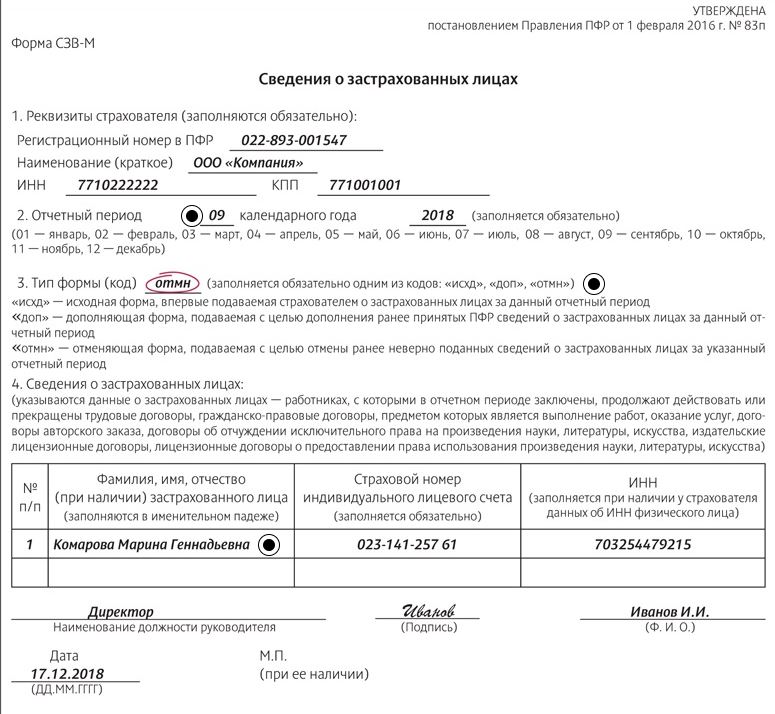

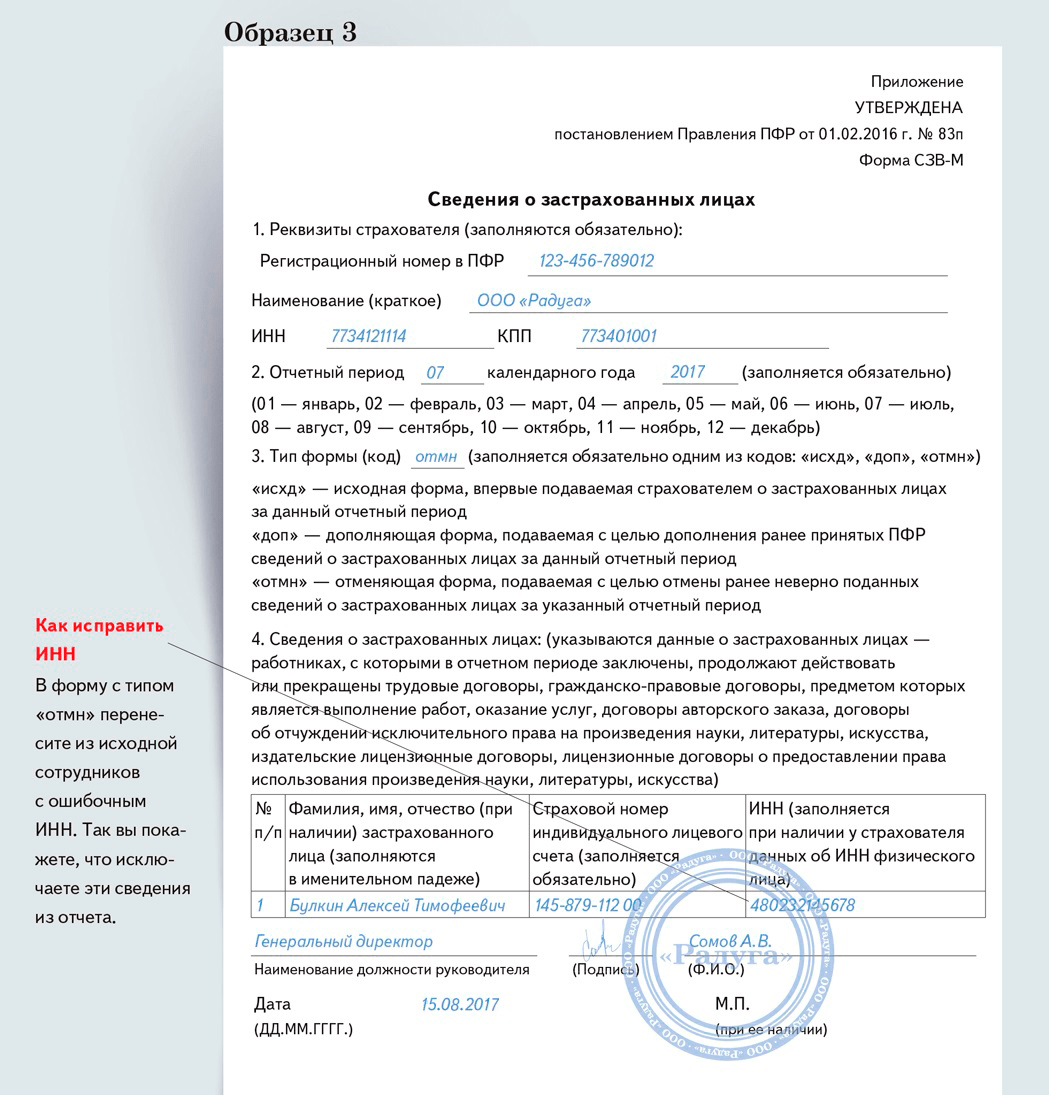

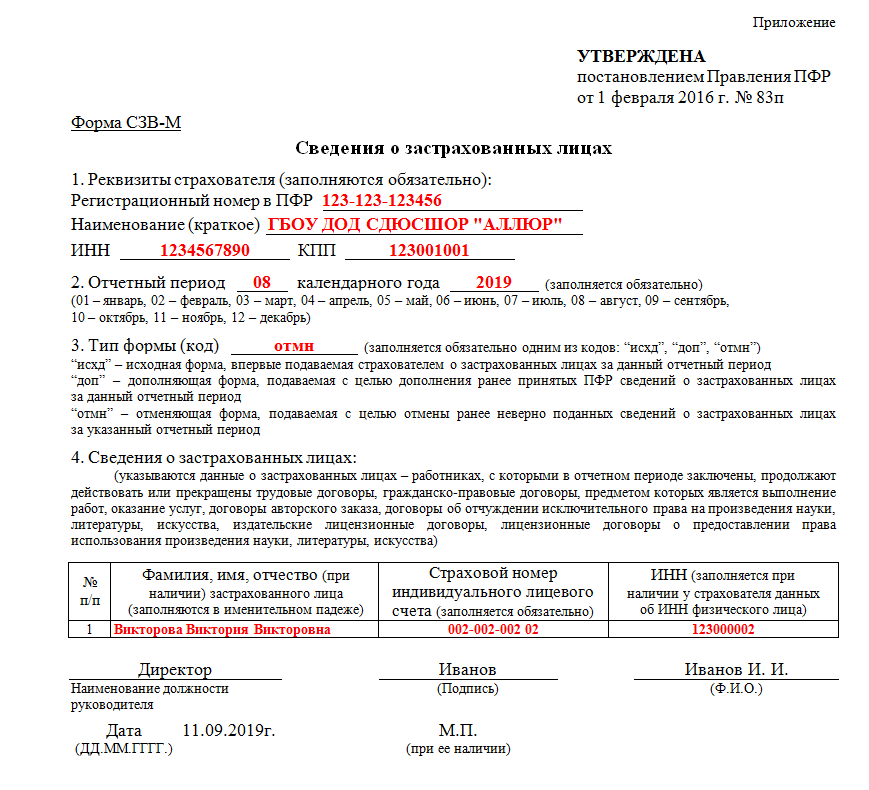

Как исправить ошибку в отчете

Чтобы исправить ошибку в сведениях отчета по форме СЗВ-М, необходимо заполнить и отправить дополняющую/отменяющую форму.

Остались вопросы?

Наши специалисты свяжутся с вами, чтобы уточнить подробности!

Использование машины опорных векторов для улучшения диагностики неисправностей коробок передач

Коробки передач — это механические устройства, которые играют важную роль в нескольких приложениях, например, в трансмиссии автомобилей. Их неисправность может привести, в частности, к экономическим потерям и несчастным случаям. Появление мощных графических процессоров позволяет использовать решения на основе глубокого обучения для решения многих проблем, включая диагностику неисправностей редукторов. Эти решения обычно требуют значительного объема данных, высокой вычислительной мощности и длительного процесса обучения.Обучение систем на основе глубокого обучения может оказаться невозможным, если графические процессоры недоступны. В этой статье предлагается решение для сокращения времени обучения систем диагностики неисправностей на основе глубокого обучения без ущерба для их точности. Решение основано на использовании этапа принятия решения для интерпретации всех вероятностных выходов классификатора, выходной слой которого имеет функцию активации softmax. Для принятия решения применялись два алгоритма классификации. Мы сократили время обучения почти на 80% без ущерба для средней точности системы диагностики неисправностей.

Их неисправность может привести, в частности, к экономическим потерям и несчастным случаям. Появление мощных графических процессоров позволяет использовать решения на основе глубокого обучения для решения многих проблем, включая диагностику неисправностей редукторов. Эти решения обычно требуют значительного объема данных, высокой вычислительной мощности и длительного процесса обучения.Обучение систем на основе глубокого обучения может оказаться невозможным, если графические процессоры недоступны. В этой статье предлагается решение для сокращения времени обучения систем диагностики неисправностей на основе глубокого обучения без ущерба для их точности. Решение основано на использовании этапа принятия решения для интерпретации всех вероятностных выходов классификатора, выходной слой которого имеет функцию активации softmax. Для принятия решения применялись два алгоритма классификации. Мы сократили время обучения почти на 80% без ущерба для средней точности системы диагностики неисправностей.

1. Введение

Редукторы — это механические устройства, которые обеспечивают преобразование скорости и крутящего момента от вращающихся источников энергии в другие механизмы. Они играют решающую роль в нескольких приложениях, например, в промышленных вращающихся машинах, автомобилях и ветряных турбинах. Их неисправность может не только нарушить работу данной системы, но также привести к экономическим потерям и рискам безопасности [1]. Таким образом, использование быстрых и эффективных методов диагностики неисправностей необходимо, поскольку раннее обнаружение отказов позволяет более эффективно управлять действиями по техническому обслуживанию и приводит к более безопасной работе системы [2].

Коробки передач могут иметь несколько режимов отказа. Большинство из них связано с механическими компонентами и условиями смазки. Одним из видов отказа, требующим внимания, является поломка зубьев шестерен, которая может значительно нарушить работу машины [3].

Благодаря появлению мощных вычислительных устройств, например, графических процессоров (GPU), методы глубокого обучения стали важными инструментами в областях исследования обнаружения и диагностики неисправностей. Их превосходная производительность в приложениях, связанных с задачами классификации и обнаружения объектов, также способствовала их популяризации [4].

Их превосходная производительность в приложениях, связанных с задачами классификации и обнаружения объектов, также способствовала их популяризации [4].

В последние годы появилось множество работ, связанных с глубоким обучением и диагностикой неисправностей в коробках передач. Zhao et al. [5] предложили вариант глубоких остаточных сетей (DRN), который использует динамически взвешенные вейвлет-коэффициенты для улучшения производительности диагностического процесса. Их работа основана на отсутствии единого мнения о наиболее критических полосах частот относительно полезной информации для систем, выполняющих диагностику планетарных коробок передач.Их система находит отличительные наборы характеристик, динамически регулируя веса, применяемые к коэффициентам вейвлет-пакетов. Cabrera et al. [6] предложили использовать глубокую сверточную нейронную сеть (DCNN), обученную на усовершенствованном многослойном сверточном автокодировщике (SCAE), для определения серьезности неисправности в коробках передач. Их система выполняет неконтролируемое обнаружение иерархических частотно-временных шаблонов с помощью DCNN. SCAE улучшает производительность DCNN за счет фиксации априорных шаблонов.

Их система выполняет неконтролируемое обнаружение иерархических частотно-временных шаблонов с помощью DCNN. SCAE улучшает производительность DCNN за счет фиксации априорных шаблонов.

Кроме того, Дойч и Хе [7] используют прямую сеть глубоких убеждений (DBN) для прогнозирования оставшегося срока службы механических машин.Они сочетают в себе возможности самообучения по функциям DBN с предсказательной силой нейронных сетей с прямой связью для извлечения характеристик из сигналов вибрации, оценки целостности машины и выполнения прогнозов. Jiang et al. [8] предложили использовать многоуровневые автокодеры с шумоподавлением для диагностики неисправностей редукторов ветряных турбин. Функции изучаются в процессе неконтролируемого процесса, за которым следует контролируемый процесс точной настройки с информацией о метках для классификации.Они также используют несколько уровней шума для обучения автокодировщика и расширения возможностей изучения и классификации функций. Jiang et al. [9] также предложили систему диагностики коробки передач, основанную на многомасштабных сверточных нейронных сетях. Они объединили многомасштабное и иерархическое обучение для сбора информации в разных масштабах, улучшив производительность классификатора.

Они объединили многомасштабное и иерархическое обучение для сбора информации в разных масштабах, улучшив производительность классификатора.

Монтейро и др. [10] предложили систему диагностики неисправностей, основанную на спектрограммах преобразования Фурье (FT) и глубоких сверточных нейронных сетях.В своей работе они также обсуждали влияние глубины модели и количества доступных обучающих данных на производительность сети. Shao et al. [11] использовали трансферное обучение для диагностики неисправностей механических машин. Модель DCNN, предварительно обученная в ImageNet, с последующим процессом тонкой настройки, выполнила диагностику неисправностей. В других работах, например, Zeng et al. [12] и Liao et al. [13], используйте сверточные нейронные сети, связанные с S- и вейвлет-преобразованиями, для классификации состояния работоспособности коробки передач соответственно.

Одной из основных проблем, связанных с решениями на основе глубокого обучения для систем диагностики неисправностей, является их вычислительная нагрузка; Например, процесс обучения глубоких моделей часто бывает долгим и требует большого количества обучающих данных. Такая неудача обычно преодолевается с помощью компьютеров с мощными графическими процессорами, например, [12]. Однако такое оборудование не всегда доступно каждому. Таким образом, необходимо найти альтернативные способы снижения вычислительных затрат на решения на основе глубокого обучения без ущерба для их производительности в отношении точности.

Такая неудача обычно преодолевается с помощью компьютеров с мощными графическими процессорами, например, [12]. Однако такое оборудование не всегда доступно каждому. Таким образом, необходимо найти альтернативные способы снижения вычислительных затрат на решения на основе глубокого обучения без ущерба для их производительности в отношении точности.

В этой статье предлагается добавить этап принятия решения в выходные данные систем диагностики неисправностей на основе DCNN, которые обычно основаны на алгоритмах классификации [5, 10, 12, 13]. Выходы этих систем часто представляют вероятность того, что данный вход принадлежит к режиму отказа в данном наборе. Выбирается режим отказа, который представляет наибольшее значение вероятности. Хотя этот подход оказался разумным для ряда приложений, информация, предоставляемая оставшимися выходными данными, обычно теряется.

Мы полагаем, что эта информация также может быть использована для повышения производительности классификатора. Примером является тот, который проанализирован в [6, 7], где ставится проблема диагностики серьезности неисправности, связанной с режимом отказа из-за поломки зуба шестерни. На этапе принятия решения анализируются выходные данные всех классов, то есть уровней серьезности, и определяется серьезность неисправности коробки передач на основе их распределения вероятностей. Поскольку эта уловка улучшает результаты классификации, ту же архитектуру модели можно обучить за меньшее количество эпох без ущерба для ее точности, тем самым сокращая время обучения.С другой стороны, этапы принятия решения — хорошо известные инструменты. Они обычно используются в мультимодальных системах классификации и системах классификации на основе комитетов. Они объединяют результаты, полученные несколькими классификаторами, для повышения точности всей системы [14, 15].

На этапе принятия решения анализируются выходные данные всех классов, то есть уровней серьезности, и определяется серьезность неисправности коробки передач на основе их распределения вероятностей. Поскольку эта уловка улучшает результаты классификации, ту же архитектуру модели можно обучить за меньшее количество эпох без ущерба для ее точности, тем самым сокращая время обучения.С другой стороны, этапы принятия решения — хорошо известные инструменты. Они обычно используются в мультимодальных системах классификации и системах классификации на основе комитетов. Они объединяют результаты, полученные несколькими классификаторами, для повышения точности всей системы [14, 15].

Остальная часть этого документа определяется следующим образом: Раздел 3 представляет детали экспериментов, проведенных в этом исследовании, Раздел 4 представляет полученные результаты и обсуждает их актуальность, а Раздел 5 объясняет основные выводы и последствия этой работы.

2. Теоретические основы

2.

1. Сверточные нейронные сети

1. Сверточные нейронные сети Сверточные нейронные сети — это модели, вдохновленные биологическими процессами. Схема связей между нейронами, то есть процессорами нейронных сетей, аналогична структуре зрительной коры головного мозга животных. Они хорошо выполняют задачи распознавания и классификации объектов [16]. Обнаружение объектов [17], обнаружение заболеваний [18] и диагностика неисправностей [6, 10] — вот три примера приложений, использующих CNN.Их основная структура состоит из входного слоя, чередующихся блоков сверточных и объединяющих слоев, за которыми следуют полностью связанные слои, и выходного слоя [16]. В зависимости от приложения могут произойти изменения в этой структуре. Эта структура проиллюстрирована на рисунке 1. Роль каждого уровня поясняется следующим образом: (a) Входной уровень: этот уровень получает и хранит необработанные входные данные. Он также определяет ширину, высоту и количество каналов входных данных [19]. (B) Сверточные слои: они изучают представления объектов из набора входных данных и генерируют карты признаков. Эти карты создаются путем свертки их входных данных с набором изученных весов. Функция активации, например функция ReLU, применяется к выходу этапа свертки. Следующее уравнение показывает общую формулировку сверточного слоя: в котором l относится к текущему слою, i и j — это индексы элементов предыдущего и текущего слоев, соответственно, это набор входных данных. maps, k — матрица весов сверточного ядра i -го слоя l , примененная к j -й входной карте признаков, а b — смещение.(c) Объединение слоев: они уменьшают пространственное разрешение карт признаков, улучшая пространственную инвариантность к входным искажениям и переносам [19]. В большинстве недавних работ используется разновидность этого уровня, называемая max pooling [16]. На следующие слои распространяется максимальное значение из окрестности элементов. Эта операция определяется тем, что это результат процесса объединения в отношении j -й карты признаков и элемент в местоположении ( p ; q ), содержащийся в области объединения.

Эти карты создаются путем свертки их входных данных с набором изученных весов. Функция активации, например функция ReLU, применяется к выходу этапа свертки. Следующее уравнение показывает общую формулировку сверточного слоя: в котором l относится к текущему слою, i и j — это индексы элементов предыдущего и текущего слоев, соответственно, это набор входных данных. maps, k — матрица весов сверточного ядра i -го слоя l , примененная к j -й входной карте признаков, а b — смещение.(c) Объединение слоев: они уменьшают пространственное разрешение карт признаков, улучшая пространственную инвариантность к входным искажениям и переносам [19]. В большинстве недавних работ используется разновидность этого уровня, называемая max pooling [16]. На следующие слои распространяется максимальное значение из окрестности элементов. Эта операция определяется тем, что это результат процесса объединения в отношении j -й карты признаков и элемент в местоположении ( p ; q ), содержащийся в области объединения. Процесс объединения также известен как субдискретизация [19]. (D) Полностью связанные и выходные уровни: они интерпретируют представления функций и выполняют рассуждения высокого уровня [16]. Они также вычисляют баллы для каждого выходного класса [19]. Количество выходных узлов зависит от количества классов [12].

Процесс объединения также известен как субдискретизация [19]. (D) Полностью связанные и выходные уровни: они интерпретируют представления функций и выполняют рассуждения высокого уровня [16]. Они также вычисляют баллы для каждого выходного класса [19]. Количество выходных узлов зависит от количества классов [12].

2.2. Спектрограммы преобразования Фурье

Преобразование Фурье (FT) — важный метод в области анализа сигналов. Он сообщает частотный состав данного сигнала, а также вклад каждой частоты относительно амплитуды [20].Фильтрация шума, распознавание образов и модуляция сигналов — это некоторые приложения, которые можно улучшить с помощью преобразования Фурье и его вариантов, например, дискретного преобразования Фурье (ДПФ), подходящего для обработки цифровых сигналов, и быстрого преобразования Фурье (БПФ), более эффективный алгоритм вычисления ДПФ [21].

Спектрограммы преобразования Фурье представляют сигналы с использованием информации о времени, частоте и величине. Кратковременное преобразование Фурье (STFT) — это вариант FT, обычно используемый для генерации такого рода представлений, поскольку он выполняет зависящий от времени спектральный анализ [21].Спектрограммы показывают, как спектр частот данного сигнала изменяется во времени. Спектрограммы также используются в приложениях диагностики неисправностей [10, 22].

Кратковременное преобразование Фурье (STFT) — это вариант FT, обычно используемый для генерации такого рода представлений, поскольку он выполняет зависящий от времени спектральный анализ [21].Спектрограммы показывают, как спектр частот данного сигнала изменяется во времени. Спектрограммы также используются в приложениях диагностики неисправностей [10, 22].

2.3. Машины опорных векторов

Машина опорных векторов (SVM) — это универсальный и мощный метод машинного обучения [23]. Его можно использовать для решения задач классификации (как линейной, так и нелинейной), регрессии и даже обнаружения выбросов, что делает его одним из самых популярных алгоритмов машинного обучения [23, 24]. Его использование также популярно при диагностике неисправностей вращающегося оборудования [25].Этот метод направлен на идентификацию гиперплоскостей, способных разделять наборы данных на пространственные объекты большой размерности. Разделение между наборами данных называется маржей, и SVM максимизирует маржу [23].

Линейно разделяемый набор данных позволяет SVM определять гиперплоскости, способные разделять данные на категории, независимо от количества измерений, представленных пространством признаков. Однако в большинстве приложений информация не является линейно разделимой в пространствах признаков с заданной размерностью.Таким образом, необходимо сопоставить набор данных с пространством признаков с большим количеством измерений, в котором данные будут линейно разделяемыми. Этот процесс отображения выполняется с использованием ядер, например ядер полиномиальных и радиальных базисных функций [23, 24].

2.4. Многослойный персептрон

Многослойный персептрон (MLP) — это нейронная сеть прямого распространения. MLP могут различать нелинейно разделяемые шаблоны. Эти алгоритмы состоят из нескольких узлов, называемых «нейронами», которые расположены на нескольких уровнях, как ориентированный граф.Каждый слой полностью связан с последующим. Эти слои обычно делятся на три типа: входные, скрытые и выходные. Многослойные персептроны считаются универсальными приближениями. Один MLP скрытого слоя с достаточным количеством нейронов может аппроксимировать любую заданную непрерывную функцию [23, 24].

Многослойные персептроны считаются универсальными приближениями. Один MLP скрытого слоя с достаточным количеством нейронов может аппроксимировать любую заданную непрерывную функцию [23, 24].

3. Материалы и методы

3.1. Экспериментальная установка: получение сигналов вибрации

Мы расположили экспериментальную установку в соответствии с рисунком 2. Она использовалась для получения измерений вибрации редуктора.Электродвигатель (M) приводит в движение коробку передач, состоящую из двух шестерен (Z1 и Z2). Эти шестерни установлены на независимых валах. Магнитный тормоз (B) подключен к выходному валу. В таблице 1 перечислены некоторые особенности этих компонентов.

| ||||||||||||||||

Кроме того, привод скорости Danfoss VLT 1: 5 кВт приводит в движение электродвигатель, а источник напряжения TDK Lambda (GEN 150-10, 0–150 В, 10 А) приводит в действие магнитный тормоз. Однонаправленный акселерометр ( A, ), который был вертикально установлен на коробке передач, рядом с входным валом, собирает сигналы вибрации. Этот акселерометр представляет собой датчик IMI 603C01, 100 мВ / г. Карта сбора данных NI9234 выполняет оцифровку аналоговых сигналов. Эта карта имеет разрешение 24 бита, частоту дискретизации 50 кГц и предназначена для пьезоэлектрических датчиков.

Однонаправленный акселерометр ( A, ), который был вертикально установлен на коробке передач, рядом с входным валом, собирает сигналы вибрации. Этот акселерометр представляет собой датчик IMI 603C01, 100 мВ / г. Карта сбора данных NI9234 выполняет оцифровку аналоговых сигналов. Эта карта имеет разрешение 24 бита, частоту дискретизации 50 кГц и предназначена для пьезоэлектрических датчиков.

Как упоминалось ранее, предлагаемый эксперимент направлен на использование сигналов вибрации редуктора для оценки серьезности поломок зубьев косозубых шестерен.Для этого один зуб косозубой шестерни Z1 был поврежден разной степени. С другой стороны, шестерня Z2 не претерпела изменений. Было учтено десять сценариев, то есть один для передачи Z1 в исправном состоянии, а остальные — для девяти уровней серьезности неисправности передачи Z1. Эти сценарии перечислены на рисунке 3 и в таблице 2.

| |||||||||||||||||||||||||||||||||||||||||

Мы также рассмотрели редуктор, работающий в различных условиях эксплуатации; то есть мы учли разные нагрузки и скорости вращения. Скорость вращения имела пять сценариев, в трех из которых она была постоянной, а в остальных — переменной. С другой стороны, нагрузка, прикладываемая магнитной тормозной системой, имела три сценария, в которых нагрузка имела постоянные значения.Эти сценарии подробно описаны в таблицах 3 и 4 для скоростей вращения и нагрузок соответственно.

| |||||||||||||||||||||||||||

| ||||||||||||||

Мы регистрировали каждую выборку вибросигнала за интервал времени 10 с. Кроме того, мы выполнили каждый комбинированный сценарий по три раза. Таким образом, база данных изначально состоит из 45 сигналов для каждой степени серьезности сбоя, то есть сбалансированная база данных из 450 сигналов, учитывающих все десять уровней серьезности. Величина этих сигналов была нормализована до диапазона [0, 1] и разделена на фрагменты длиной 0,25 секунды, в результате чего было получено 1800 сигналов для каждого уровня серьезности неисправности и 18000 сигналов во всей сбалансированной базе данных.

Кроме того, мы выполнили каждый комбинированный сценарий по три раза. Таким образом, база данных изначально состоит из 45 сигналов для каждой степени серьезности сбоя, то есть сбалансированная база данных из 450 сигналов, учитывающих все десять уровней серьезности. Величина этих сигналов была нормализована до диапазона [0, 1] и разделена на фрагменты длиной 0,25 секунды, в результате чего было получено 1800 сигналов для каждого уровня серьезности неисправности и 18000 сигналов во всей сбалансированной базе данных.

3.2. Экспериментальная установка: обучение системе классификации

Система, предложенная для оценки серьезности неисправности редуктора, основана на архитектуре глубокой сверточной нейронной сети.Таким образом, было необходимо двумерное представление входных сигналов. Мы решили представить их в частотно-временной области, так как такое представление позволяет визуализировать, когда возникают определенные частотные компоненты, связанные с отказом.

Кратковременное преобразование Фурье — это метод, который мы использовали для создания двумерного представления сигналов, то есть спектрограмм преобразования Фурье. STFT имеет низкие вычислительные затраты, чем другие методы частотно-временного представления [26].Эта характеристика особенно важна для предлагаемой системы, поскольку мы имеем дело с приложением реального времени. Конфигурация STFT включала окно Хэмминга размером 128 с перекрытием, равным 50%. Эти варианты сочетали селективное свойство окна Хэмминга с балансом между плавным изменением результирующего сигнала и низкими вычислительными затратами.

STFT имеет низкие вычислительные затраты, чем другие методы частотно-временного представления [26].Эта характеристика особенно важна для предлагаемой системы, поскольку мы имеем дело с приложением реального времени. Конфигурация STFT включала окно Хэмминга размером 128 с перекрытием, равным 50%. Эти варианты сочетали селективное свойство окна Хэмминга с балансом между плавным изменением результирующего сигнала и низкими вычислительными затратами.

Были разработаны два экспериментальных сценария. В первом из них информация о сигнале была сжата в изображения RGB размером 175 × 175 пикселей.Этот вид данных позволяет предоставить больше информации в систему оценки серьезности неисправности, поскольку могут использоваться такие уловки, как цветовые карты. С другой стороны, это увеличивает вычислительную нагрузку на систему, потому что вход представляет 3 канала. Во втором сценарии мы использовали изображения в оттенках серого 175 × 175 пикселей. В отличие от предыдущего сценария, единственная информация, предоставляемая спектрограммами, — это величина преобразования Фурье. На рисунке 4 показан пример спектрограммы, полученной описанным способом.

На рисунке 4 показан пример спектрограммы, полученной описанным способом.

Система классификации, используемая в этой работе, состоит из трех сверточных слоев, трех слоев максимального объединения, одного полностью связного слоя и одного выходного уровня. Поскольку выходы такой структуры представляют собой значения вероятности в диапазоне от 0 до 1, функция активации softmax использовалась в нейронах выходного слоя, а функция активации ReLU использовалась в нейронах остальных слоев. Согласно Монтейро и соавт., Эта архитектура обеспечивает удовлетворительные характеристики при оценке серьезности неисправностей редукторов.[10]. Это проиллюстрировано на рисунке 5. Кроме того, машина опорных векторов использовалась для анализа выходных данных системы и повышения ее производительности. Этот алгоритм уже использовался в подобных приложениях, например, предложенный Ли и др. [27], в котором SVM использовался для объединения результатов классификаторов, работающих с мультимодальными данными.

Что касается шага обучения, данные были разделены на три группы: обучение, тестирование и проверка. Мы использовали набор данных проверки, чтобы уменьшить возникновение проблем, связанных с переобучением.Каждый из них содержит соответственно 50%, 25% и 25% сбалансированных сигналов для каждого уровня серьезности неисправности. Тренировочный процесс проводился по 10-ти и 50-ти эпохным сценариям. Конфигурация компьютера, используемого для обучения модели, включала ОС Windows 10 Home, 64 бита, память (ОЗУ) 15,9 ГБ, процессор Intel® Core ™ i7-6500 CPU @ 2,50 ГГц × 2 и AMD Radeon ™ T5 M330 (без CUDA поддерживать).

4. Результаты и обсуждение

Первое обсуждение касается времени обучения системы диагностики неисправностей, основанной на глубоких сверточных нейронных сетях.Хорошо известно, что компьютеры с графическими процессорами намного лучше справляются с вычислительной нагрузкой, связанной с решениями глубокого обучения, чем компьютеры с процессорами. С другой стороны, компьютеры с графическими процессорами более дорогие, а это означает, что они не всегда доступны. Таблица 5 иллюстрирует эту проблему. Он показывает среднее время обучения 30 DCNN (в каждом сценарии) с архитектурой, упомянутой в последнем разделе, в отношении компьютеров с различными конфигурациями и набора данных изображения RGB. Модели обучались в 50 эпох.Мы обучили это количество моделей, чтобы гарантировать статистическую релевантность результатов. Первую компьютерную конфигурацию (компьютер с графическим процессором) использовали Монтейро и др. [10]. Он состоял из ОС Ubuntu 16.04 LTS, 64 бита, памяти 15,6 ГБ, процессора Intel Xeon (R) CPU E 5-2609 v3 @ 1,90 ГГц × 12 и графики Gallium 0.4 на NV117. Второй был представлен в предыдущем разделе.

С другой стороны, компьютеры с графическими процессорами более дорогие, а это означает, что они не всегда доступны. Таблица 5 иллюстрирует эту проблему. Он показывает среднее время обучения 30 DCNN (в каждом сценарии) с архитектурой, упомянутой в последнем разделе, в отношении компьютеров с различными конфигурациями и набора данных изображения RGB. Модели обучались в 50 эпох.Мы обучили это количество моделей, чтобы гарантировать статистическую релевантность результатов. Первую компьютерную конфигурацию (компьютер с графическим процессором) использовали Монтейро и др. [10]. Он состоял из ОС Ubuntu 16.04 LTS, 64 бита, памяти 15,6 ГБ, процессора Intel Xeon (R) CPU E 5-2609 v3 @ 1,90 ГГц × 12 и графики Gallium 0.4 на NV117. Второй был представлен в предыдущем разделе.

| ||||||||||||

Можно заметить, что процесс обучения для компьютера без GPU был намного дольше, чем для компьютера с GPU; я. е. было примерно в 13 раз дольше. В некоторых ситуациях, в зависимости от объема данных или доступного времени, использование компьютеров без графических процессоров может оказаться непрактичным.

е. было примерно в 13 раз дольше. В некоторых ситуациях, в зависимости от объема данных или доступного времени, использование компьютеров без графических процессоров может оказаться непрактичным.

Для решения этой проблемы можно сделать несколько вариантов. Уменьшение количества тренировочных эпох — одна из них. Как видно из Таблицы 6, уменьшение количества тренировочных эпох с 50 до 10 уменьшило среднее время тренировки примерно на 78,7%. С другой стороны, такое сокращение сказывается на производительности. Средняя точность снизилась примерно на 1.8%. Такое поведение уже ожидалось, поскольку у моделей было меньше итераций для изучения особенностей обучающих данных. Результаты в таблице 6 были получены путем обучения 30 сетей DCNN в каждом сценарии.

| ||||||||||||||||||

Прежде чем предлагать модификации системы диагностики неисправностей, необходимо определить основные трудности модели. В качестве эталона мы взяли модель, обученную за 10 эпох. В таблице 7 перечислены средние значения и значения стандартного отклонения точности для 30 моделей. Можно заметить, что для некоторых классов, например, P1 и P2, система показывала высокие значения точности, т.е. близкие к 100%.С другой стороны, модели показали низкую производительность для входных данных из таких классов, как P6 и P7.

| |||||||||||||||||||||||||||||||||||||||||

Этот анализ можно углубить, наблюдая за выходными данными классификатора.На рисунке 6 показано, как выходные вероятности моделей распределяются в соответствии с классом входного изображения. Что касается входов, принадлежащих к классу P1, можно заметить, что выходные вероятности моделей были очень близки к 1 для класса P1 и очень близки к 0 для других. Это помогает понять, почему точность модели для этого класса была 100%. С другой стороны, профили распределения, принадлежащие классам P6 и P7, показывают, что выходы сетей не были такими точными, как в предыдущем случае. Действительно, выбор только тех выходных данных, которые представляют наибольшее значение вероятности, может привести к неправильной классификации из-за значительного присутствия выбросов.

Действительно, выбор только тех выходных данных, которые представляют наибольшее значение вероятности, может привести к неправильной классификации из-за значительного присутствия выбросов.

Для решения этой проблемы мы предложили решение, основанное на использовании выходных вероятностей всех десяти классов для выполнения правильной классификации. Такое решение можно реализовать несколькими способами. Один из них — использование неглубоких классификаторов, например, многослойного персептрона или машины опорных векторов. Эти классификаторы идентифицируют класс серьезности передачи, используя информацию, содержащуюся в выходных вероятностях глубокой сверточной нейронной сети.Таким образом, отклик системы получается путем анализа распределения вероятностей, а не только одного значения.

В этом исследовании мы использовали машину опорных векторов. Он был обучен с выходными данными DCNN относительно ранее установленных данных обучения. Результаты предложенной модификации перечислены в таблицах 8 и 9. Таблица 8 показывает средние результаты каждого класса по 30 моделям и сравнивает их с результатами сценария без дополнительного классификатора. В таблице 9 показаны средние результаты для всех классов и моделей, а также в сравнении со сценарием без дополнительного классификатора.

Таблица 8 показывает средние результаты каждого класса по 30 моделям и сравнивает их с результатами сценария без дополнительного классификатора. В таблице 9 показаны средние результаты для всех классов и моделей, а также в сравнении со сценарием без дополнительного классификатора.

| |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| ||||||||||||||||||

Из таблицы 8 можно сделать вывод, что включение классификатора улучшило характеристики модели по всем 10 классам , как в отношении средней точности, так и стандартного отклонения. Кроме того, из Таблицы 9 можно заметить, что средняя точность увеличилась примерно на 2,56% за счет увеличения менее чем на 1 секунду среднего времени обучения. Эти результаты еще более значительны по сравнению с результатами, полученными в процессе обучения с 50 эпохами, представленными в таблице 5. Средняя точность предложенной модели была только на 0,76% выше, но при среднем времени обучения на 78,64% меньше. Это значительно ускорило обучение системы диагностики неисправностей. Кроме того, мы использовали два дополнительных показателя, чтобы гарантировать надежность полученных результатов: F -score и AUC. Первый — это среднее гармоническое значение точности и отзыва.Второй показатель, с другой стороны, определяется как площадь под кривой рабочей характеристики приемника (ROC). Их средние значения перечислены в Таблице 10, и оба они показывают тенденцию к улучшению, совпадающую с тенденцией, наблюдаемой в Таблице 9, то есть система диагностики с классификатором представила значения для показателей примерно на 2% выше, чем без классификатора.

Эти результаты еще более значительны по сравнению с результатами, полученными в процессе обучения с 50 эпохами, представленными в таблице 5. Средняя точность предложенной модели была только на 0,76% выше, но при среднем времени обучения на 78,64% меньше. Это значительно ускорило обучение системы диагностики неисправностей. Кроме того, мы использовали два дополнительных показателя, чтобы гарантировать надежность полученных результатов: F -score и AUC. Первый — это среднее гармоническое значение точности и отзыва.Второй показатель, с другой стороны, определяется как площадь под кривой рабочей характеристики приемника (ROC). Их средние значения перечислены в Таблице 10, и оба они показывают тенденцию к улучшению, совпадающую с тенденцией, наблюдаемой в Таблице 9, то есть система диагностики с классификатором представила значения для показателей примерно на 2% выше, чем без классификатора.

| ||||||||||||||||||

Что касается среднего времени для выполнения классификации одного единственного входа, добавление стадии принятия решения не привело к существенные изменения. Действительно, среднее время классификации, составлявшее около 0,03 секунды без этапа принятия решения, увеличилось менее чем на 0,001 секунды.

Чтобы оценить, насколько значительными были улучшения, обеспечиваемые предложенным решением, ранжированный по сигналу статистический тест Вилкоксона может быть применен к выходам систем диагностики неисправностей с этапом принятия решения и без него.Результаты приведены в таблице 10. Тест Вилкоксона — это непараметрический тест гипотезы, который можно использовать для оценки того, эквивалентны ли два распределения или нет [28]. Если это не так, это означает, что произошло статистически значимое улучшение (символ Λ). В противном случае улучшение не было значительным (- символ). Таблица 11 показывает, что у нас были значительные улучшения для классов P4, P5, P6, P7 и P9. Хотя остальные классы также показали некоторое улучшение, они не были статистически значимыми.

В противном случае улучшение не было значительным (- символ). Таблица 11 показывает, что у нас были значительные улучшения для классов P4, P5, P6, P7 и P9. Хотя остальные классы также показали некоторое улучшение, они не были статистически значимыми.

| |||||||||||||||||||||||||||||

Мы также проанализировали производительность этапа принятия решения, когда применялся другой алгоритм классификации. Этот алгоритм представлял собой многослойный персептрон, т.е. нейронную сеть. Мы устанавливаем размер входного слоя равным 10, скрытого слоя с 21 нейроном и выходного слоя с одним нейроном. Мы развернули логистическую сигмоиду в качестве функции активации. Мы установили количество эпох обучения равным 200. Количество обучающих, тестовых и проверочных выборок осталось таким же, как в сценарии SVM. Мы обучили 30 MLP, чтобы гарантировать статистическую релевантность результатов. Мы показываем результаты для SVM и MLP в таблицах 12 и 13.В таблице 12 перечислены средние значения F 1-балла, AUC и точности. В Таблице 13 указано среднее время тренировки и бега.

Этот алгоритм представлял собой многослойный персептрон, т.е. нейронную сеть. Мы устанавливаем размер входного слоя равным 10, скрытого слоя с 21 нейроном и выходного слоя с одним нейроном. Мы развернули логистическую сигмоиду в качестве функции активации. Мы установили количество эпох обучения равным 200. Количество обучающих, тестовых и проверочных выборок осталось таким же, как в сценарии SVM. Мы обучили 30 MLP, чтобы гарантировать статистическую релевантность результатов. Мы показываем результаты для SVM и MLP в таблицах 12 и 13.В таблице 12 перечислены средние значения F 1-балла, AUC и точности. В Таблице 13 указано среднее время тренировки и бега.

| ||||||||||||||||||||||||

| ||||||||||||||||||

Что касается показателей, несмотря на небольшое преимущество, представленное этапом принятия решения SVM в отношении точности, был предложен тест Уилкоксона. что результаты, достигнутые обоими алгоритмами, были одинаковыми.Это означает, что предлагаемое решение может быть реализовано с другими классификаторами, кроме SVM. С другой стороны, интересный факт возникает из времени тренировок и бега. Процесс обучения на этапе принятия решения MLP был примерно в 7,1 раза дольше, чем у SVM, тогда как время выполнения было более чем в 20 раз быстрее. Правильное решение с учетом этого компромисса может быть привлекательным в зависимости от предполагаемого приложения.

Правильное решение с учетом этого компромисса может быть привлекательным в зависимости от предполагаемого приложения.

Эти анализы с этапом принятия решения SVM были также выполнены в отношении изображений спектрограммы в градациях серого.Они стремились оценить, как система диагностики неисправностей справится с сокращением доступной информации. Таблица 14 показывает среднюю точность и среднее время обучения для 30 моделей, относящихся к каждому сценарию. В этих сценариях рассматривались модели, обученные с использованием изображений RGB и изображений в градациях серого для 10 эпох. При расчете средней точности использовались только тестовые данные. Один заметил, что модель, обученная с использованием изображений RGB, дает лучшие результаты в отношении точности, то есть примерно на 10% выше.С другой стороны, среднее время обучения моделей, обученных с изображениями в оттенках серого, было меньше. Вероятно, это произошло из-за меньшего количества обработанной информации.

| ||||||||||||||||||

Таблица 15 и рисунок 7 помогают понять, что происходит с производительностью модели классификации, обученной с использованием изображений в градациях серого, относительно всех десяти классов. Можно заметить, что относительно сценария RGB даже результаты классов, подобных P1, ухудшились как по средней точности, так и по стандартному отклонению. На рисунке 7 показано, как вероятности выхода DCNN распределяются в соответствии с классом входного изображения.Для другого сценария количество выбросов значительно увеличилось. Такое поведение произошло со всеми классами.

| |||||||||||||||||||||||||||||||||||||||||

Также в этом сценарии используется новый сценарий , мы намерены оценить, может ли предлагаемое решение улучшить производительность классификатора на основе DCNN, используя выходные вероятности всех 10 классов.

Результаты, полученные с использованием машины опорных векторов, обученной с выходными данными глубоких сверточных нейронных сетей, перечислены в таблицах 16 и 17. Таблица 16 показывает средние результаты для каждого класса относительно 30 обученных моделей. Эти результаты сравниваются с результатами сценария без дополнительного классификатора. Таблица 17 показывает средние результаты по всем классам и моделям, а также сравнивает их со сценарием без дополнительной стадии. Из таблицы 16 можно сделать вывод, что включение классификатора улучшило производительность модели по всем десяти классам, как в отношении средней точности, так и стандартного отклонения.С другой стороны, даже эти улучшенные системы не смогли превзойти те, которые обучены с изображениями спектрограмм RGB, как видно из таблицы 14. Кроме того, из таблицы 17 можно заметить, что средняя точность увеличилась примерно на 4,18% за счет уменьшения менее 1 секунды до среднего времени обучения. Это относительное улучшение было выше, чем в предыдущем экспериментальном сценарии. В таблице 18 показаны средние значения F и AUC для систем с этапом принятия решения и без него.В таблице 18 показаны средние значения F и AUC для систем с этапом принятия решения и без него. Эти два показателя усиливают тенденцию к улучшению, вызванную добавлением стадии принятия решения.

Таблица 17 показывает средние результаты по всем классам и моделям, а также сравнивает их со сценарием без дополнительной стадии. Из таблицы 16 можно сделать вывод, что включение классификатора улучшило производительность модели по всем десяти классам, как в отношении средней точности, так и стандартного отклонения.С другой стороны, даже эти улучшенные системы не смогли превзойти те, которые обучены с изображениями спектрограмм RGB, как видно из таблицы 14. Кроме того, из таблицы 17 можно заметить, что средняя точность увеличилась примерно на 4,18% за счет уменьшения менее 1 секунды до среднего времени обучения. Это относительное улучшение было выше, чем в предыдущем экспериментальном сценарии. В таблице 18 показаны средние значения F и AUC для систем с этапом принятия решения и без него.В таблице 18 показаны средние значения F и AUC для систем с этапом принятия решения и без него. Эти два показателя усиливают тенденцию к улучшению, вызванную добавлением стадии принятия решения.

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| Средняя точность (%) | Среднее время обучения (с) | |

| Без классификатора | 84. 98 98 | 1967 |

| С классификатором | 89,16 | 1968 |

| |||||||||||||||||

Что касается среднего времени классификации, в этом сценарии добавление стадии принятия решения также не привело к значительным изменениям. Оно увеличилось с 0,022 секунды до менее 0,023 секунды.

Чтобы оценить, насколько значительным было улучшение, обеспечиваемое предложенным решением в этом новом сценарии, статистический тест Уилкоксона с ранжированием сигналов также был применен к выходам систем диагностики неисправностей с этапом принятия решения и без него. Результаты перечислены в таблице 19, которая показывает, что мы добились значительных улучшений для классов P4, P5, P6, P7, P8 и P10. Еще раз, хотя другие классы также показали улучшения, они не были значительными.

Результаты перечислены в таблице 19, которая показывает, что мы добились значительных улучшений для классов P4, P5, P6, P7, P8 и P10. Еще раз, хотя другие классы также показали улучшения, они не были значительными.

| ||||||||||||||||||||||||||||

5.Выводы

Мы проанализировали использование этапа принятия решения для интерпретации выходных данных системы диагностики неисправностей, основанной на глубоких сверточных нейронных сетях. Эти выходы соответствуют вероятности того, что вход принадлежит классам данного набора. Таким образом, вместо использования традиционного подхода, такого как выбор класса с наибольшим значением вероятности, мы проанализировали выходное распределение глубокого классификатора, чтобы выполнить более надежную диагностику неисправностей.

Эти выходы соответствуют вероятности того, что вход принадлежит классам данного набора. Таким образом, вместо использования традиционного подхода, такого как выбор класса с наибольшим значением вероятности, мы проанализировали выходное распределение глубокого классификатора, чтобы выполнить более надежную диагностику неисправностей.

Результаты показали, что мы можем повысить точность системы классификации и сократить почти 80% времени обучения без ущерба для времени выполнения, которое увеличилось примерно на 0.001 секунда. Это улучшение особенно важно для ситуаций, в которых мощное оборудование, например графические процессоры, недоступно. Таким образом, система диагностики неисправностей с заданным значением точности может быть получена с использованием лишь небольшой части времени обучения, которое потребовалось бы для выполнения полного обучения. Эти результаты были достигнуты за счет использования SVM в качестве принимающего решения, который имел выходные вероятности исходной системы диагностики неисправностей в качестве входной информации. Аналогичные результаты были достигнуты при внедрении MLP в качестве лица, принимающего решения. Это предполагает, что предлагаемое решение также может быть реализовано с помощью алгоритмов, отличных от SVM.

Аналогичные результаты были достигнуты при внедрении MLP в качестве лица, принимающего решения. Это предполагает, что предлагаемое решение также может быть реализовано с помощью алгоритмов, отличных от SVM.

Мы также оценили использование входных спектрограмм RGB и оттенков серого. Хотя добавление стадии принятия решения привело к улучшениям в обоих сценариях, эти улучшения имели разные масштабы. Точность систем, работающих с изображениями в градациях серого, повысилась больше, чем в другом сценарии. Однако конечная точность этих систем, обученных на изображениях RGB, была лучше.Такое поведение можно объяснить количеством информации, доступной в каждом виде изображения, как обсуждалось ранее. Кроме того, мы увидели, что разница во времени выполнения в обоих сценариях не была существенной в отношении абсолютных значений. Таким образом, это предполагает, что использование изображений RGB не поставит под угрозу работу системы в приложениях реального времени.

Будущие работы касаются применения этой методологии диагностики неисправностей к другим видам отказов и для проблем, относящихся к различным физическим областям, например. g., диагностика неисправностей с помощью акустики. Более того, мы можем оценить производительность других алгоритмов, используемых в качестве лиц, принимающих решения.

g., диагностика неисправностей с помощью акустики. Более того, мы можем оценить производительность других алгоритмов, используемых в качестве лиц, принимающих решения.

Доступность данных

Данные, использованные для подтверждения результатов этого исследования, включены в статью.

Конфликт интересов

Авторы заявляют, что у них нет конфликта интересов.

Полное руководство по опорных векторов (SVM) | Марко Пейшейро

Поймите его внутреннюю работу и реализуйте SVM в четырех различных сценариях

Что бы мы делали без sklearn?Мы увидели, как подойти к проблеме классификации с помощью логистической регрессии, LDA и деревьев решений.Теперь появился еще один инструмент для классификации: машина опорных векторов .

Машина опорных векторов является обобщением классификатора под названием классификатор максимальной маржи . Классификатор максимальной маржи прост, но его нельзя применить к большинству наборов данных, поскольку классы должны быть разделены линейной границей.

Вот почему классификатор опорных векторов был введен как расширение классификатора максимальной маржи, которое может применяться в более широком диапазоне случаев.

Наконец, машина опорных векторов — это просто дальнейшее расширение классификатора опорных векторов для учета нелинейных границ классов.

Может использоваться как для двоичной, так и для мультиклассовой классификации.

Изложение теории SVM может быть очень техническим. Надеюсь, эта статья упростит понимание того, как работают SVM.

Когда теория раскрыта, вы сможете реализовать алгоритм в четырех различных сценариях!

Без дополнительной оплаты, перейдем к делу.

Нет SVM-гифок .. поэтому мне пришлось довольствоваться «машинным» gifЧтобы найти практические видеоуроки по машинному обучению, глубокому обучению и искусственному интеллекту, посетите мой канал YouTube.

Этот метод основан на разделении классов с помощью гиперплоскости.

Что такое гиперплоскость?

В пространстве размерности p гиперплоскость — это плоское аффинное подпространство размерности p-1 . Визуально в 2D-пространстве гиперплоскость будет линией, а в 3D-пространстве — плоской.

Математически гиперплоскость выглядит просто:

Общее уравнение гиперплоскостиЕсли X удовлетворяет приведенному выше уравнению, то точка лежит на плоскости. В противном случае он должен быть на одной стороне плоскости, как показано ниже.

Линия представляет собой гиперплоскость в двухмерном пространстве. Точки, удовлетворяющие приведенному выше уравнению, будут лежать на линии, а другие — по одну сторону от плоскости.В общем, если данные могут быть идеально разделены с помощью гиперплоскости, то существует бесконечное количество гиперплоскостей, поскольку их можно сдвинуть вверх или вниз или немного повернуть, не соприкасаясь с наблюдением.

Вот почему мы используем гиперплоскость максимального запаса или оптимальную разделяющую гиперплоскость , которая является самой удаленной от наблюдений разделяющей гиперплоскостью. Мы вычисляем перпендикулярное расстояние от каждого тренировочного наблюдения с учетом гиперплоскости. Это поле известно как маржа . Следовательно, оптимальная разделяющая гиперплоскость — это гиперплоскость с наибольшим запасом.

Мы вычисляем перпендикулярное расстояние от каждого тренировочного наблюдения с учетом гиперплоскости. Это поле известно как маржа . Следовательно, оптимальная разделяющая гиперплоскость — это гиперплоскость с наибольшим запасом.

Как вы можете видеть выше, есть три точки, равноудаленные от гиперплоскости.Эти наблюдения известны как опорных векторов , потому что, если их положение смещается, гиперплоскость также смещается. Интересно, что это означает, что гиперплоскость зависит только от опорных векторов, а не от каких-либо других наблюдений.

Что делать, если разделяющей плоскости не существует?

Перекрывающиеся классы, в которых не существует разделяющей гиперплоскости. В этом случае классификатор максимального поля отсутствует. Мы используем классификатор опорных векторов, который может почти разделить классы с помощью мягкого поля , называемого классификатором опорных векторов . Однако дальнейшее обсуждение этого метода становится очень техническим, и, поскольку это не самый идеальный подход, мы пока пропустим эту тему.

Однако дальнейшее обсуждение этого метода становится очень техническим, и, поскольку это не самый идеальный подход, мы пока пропустим эту тему.

Машина опорных векторов — это расширение классификатора опорных векторов, которое является результатом увеличения пространства признаков с использованием ядер . Подход ядра — это просто эффективный вычислительный подход для размещения нелинейной границы между классами.

Не вдаваясь в технические подробности, ядро - это функция, которая количественно определяет сходство двух наблюдений.Ядро может быть любой степени. Использование ядра со степенью больше единицы приводит к более гибкой границе принятия решений, как показано ниже.

Пример классификации с SVMЧтобы лучше понять, как выбор ядра может повлиять на алгоритм SVM, давайте реализуем его в четырех различных сценариях.

Этот проект разделен на четыре мини-проекта.

В первой части будет показано, как выполнить классификацию с линейным ядром и как параметр регуляризации C влияет на результирующую гиперплоскость .

Затем во второй части будет показано, как работать с гауссовским ядром для создания нелинейной гиперплоскости.

Третья часть моделирует перекрывающиеся классы, и мы будем использовать перекрестную проверку , чтобы найти лучшие параметры для SVM.

Наконец, мы выполняем очень простой классификатор спама , используя SVM.

Упражнения, указанные выше, были взяты из курса Эндрю Нга, доступного бесплатно на Coursera. Я просто решаю их с помощью Python, что не рекомендуется инструктором.Тем не менее, я очень рекомендую курс всем новичкам.

Как всегда, записная книжка и данные доступны здесь.

Мини-проект 1 — SVM с линейным ядром

Прежде чем мы начнем, давайте импортируем несколько полезных библиотек:

Обратите внимание, что мы импортируем loadmat здесь, потому что наши данные находятся в матричной форме.

Затем мы сохраняем пути к нашим наборам данных в различных переменных:

Наконец, мы создадим функцию, которая поможет нам быстро построить каждый набор данных:

Отлично!

Теперь, в этой части, мы реализуем машину опорных векторов с использованием линейного ядра и увидим, как параметр регуляризации может повлиять на гиперплоскость.

Во-первых, загрузим и визуализируем данные:

И вы должны увидеть:

Обратите внимание на графике выше на наличие выброса с левой стороны . Давайте посмотрим, как параметр регуляризации повлияет на гиперплоскость при наличии выброса.

Приведенный выше блок кода просто подгоняет SVM к данным, и мы используем прогнозы для построения гиперплоскости. Обратите внимание, что мы используем параметр регуляризации, равный 1. Результат должен быть следующим:

Гиперплоскость с C = 1Как вы можете видеть, гиперплоскость проигнорировала выброс.Следовательно, низкий параметр регуляризации будет , лучше обобщить . Ошибка теста обычно выше, чем ошибка перекрестной проверки.

Теперь давайте увеличим параметр регуляризации:

И вы получите:

Гиперплоскость с C = 100 Теперь выброс находится на правой стороне гиперплоскости, но это также означает, что мы переоснащаем. В конечном итоге эта граница не будет работать с ненаблюдаемыми данными.

Мини-проект 2 — SVM с гауссовым ядром

Теперь мы знаем, что для учета нелинейных границ нам нужно изменить функцию ядра.В этом упражнении мы будем использовать гауссово ядро .

Сначала построим график наших данных:

И вы должны увидеть:

Перед реализацией SVM вы должны знать, что ядро Гаусса выражается как:

Функция ядра ГауссаОбратите внимание, что существует параметр сигма , который определяет как быстро показатель сходства стремится к нулю, когда они находятся дальше друг от друга.

Следовательно, реализуем это следующим кодом:

И у вас должна получиться следующая гиперплоскость:

Нелинейная гиперплоскость с гауссовым ядромУдивительно! Гиперплоскость не идеальная граница, но она неплохо справилась с классификацией большей части данных.Я предлагаю вам попробовать различные значения сигма , чтобы увидеть, как это влияет на гиперплоскость.

Мини-проект 3 — SVM с перекрестной проверкой

Перекрестная проверка необходима для выбора наилучших параметров настройки для оптимальной производительности нашей модели. Давайте посмотрим, как это можно применить к SVM.

Давайте посмотрим, как это можно применить к SVM.

Конечно, давайте посмотрим, как выглядят данные для этого упражнения:

И вы получите:

Обратите внимание, что у нас есть перекрывающиеся классы. Конечно, наша гиперплоскость не будет идеальной, но мы будем использовать перекрестную проверку, чтобы убедиться, что это лучшее, что мы можем получить:

Из приведенной выше ячейки кода вы должны получить, что лучший параметр регуляризации равен 1, и что сигма должна быть 0.1. Используя эти значения, мы можем сгенерировать гиперплоскость:

И получить:

Гиперплоскость с C = 1 и sigma = 0,1Мини-проект 4 — Классификация спама с помощью SVM

Наконец, мы обучаем классификатор спама с помощью SVM. В этом случае мы будем использовать линейное ядро. Кроме того, у нас есть отдельные наборы данных для обучения и тестирования, что немного упростит наш анализ.

И вы видите, что мы получаем точность обучения 99,825% и точность теста 98,9%!

SVM: выбор функций и ядра | автор: Пьер Паоло Ипполито

Точки данных на одной стороне гиперплоскости будут классифицированы в определенный класс, в то время как точки данных на другой стороне гиперплоскости будут классифицированы в другой класс (например,зеленый и красный, как на рисунке 2). Расстояние между гиперплоскостью и первой точкой (для всех различных классов) по обе стороны от гиперплоскости является мерой уверенности в том, что алгоритм принимает решение о классификации. Чем больше расстояние и тем увереннее мы можем быть, SVM принимает правильное решение.

Расстояние между гиперплоскостью и первой точкой (для всех различных классов) по обе стороны от гиперплоскости является мерой уверенности в том, что алгоритм принимает решение о классификации. Чем больше расстояние и тем увереннее мы можем быть, SVM принимает правильное решение.

Точки данных, ближайшие к гиперплоскости, называются опорными векторами. Опорные векторы определяют ориентацию и положение гиперплоскости, чтобы максимизировать поле классификатора (и, следовательно, оценку классификации).Количество опорных векторов, которые должен использовать алгоритм SVM, может быть произвольно выбрано в зависимости от приложений.

Базовая классификация SVM может быть легко реализована с помощью библиотеки Scikit-Learn Python в несколько строк кода.

из sklearn import svm

trainingsvm = svm.SVC (). Fit (X_Train, Y_Train)

predictionsvm = trainingsvm.predict (X_Test)

print (confusion_matrix (Y_Test, predictionsvm))

print (classification_report) (Y_vm_report)

Существует два основных типа алгоритмов классификации SVM Hard Margin и Soft Margin:

- Hard Margin: направлен на поиск наилучшей гиперплоскости, не допуская никаких форм ошибочной классификации.

- Мягкое поле: мы добавляем степень допуска в SVM. Таким образом, мы позволяем модели добровольно ошибочно классифицировать несколько точек данных, если это может привести к идентификации гиперплоскости, способной лучше обобщать невидимые данные.

Soft Margin SVM может быть реализован в Scikit-Learn путем добавления штрафного члена C в svm.SVC . Чем больше C, тем больше штраф получает алгоритм при ошибочной классификации.

Если данные, с которыми мы работаем, не разделимы линейно (что приводит к плохим результатам линейной классификации SVM), можно применить метод, известный как трюк с ядром.Этот метод может отображать наши нелинейные разделяемые данные в пространство более высокой размерности, делая наши данные линейно разделяемыми. Используя это новое размерное пространство, можно легко реализовать SVM (рис. 3).

Рисунок 3: Уловка с ядром [3] Существует много различных типов ядер, которые можно использовать для создания этого пространства более высокой размерности, некоторые примеры — линейные, полиномиальные, сигмоидальные и радиальные базисные функции (RBF). В Scikit-Learn функция ядра может быть указана путем добавления параметра ядра в

В Scikit-Learn функция ядра может быть указана путем добавления параметра ядра в svm.SVC . Можно включить дополнительный параметр под названием гамма, чтобы указать влияние ядра на модель.

Обычно предлагается использовать линейные ядра, если количество объектов больше, чем количество наблюдений в наборе данных (иначе RBF может быть лучшим выбором).

При работе с большим объемом данных с использованием RBF скорость может стать ограничением, которое необходимо учитывать.

После установки нашей линейной SVM можно получить доступ к коэффициентам классификатора, используя .coef_ на обученной модели. Эти веса определяют координаты ортогональных векторов, ортогональных гиперплоскости. Их направление представляет вместо этого предсказанный класс.

Следовательно, важность характеристики может быть определена путем сравнения размеров этих коэффициентов друг с другом. Таким образом, глядя на коэффициенты SVM, можно определить основные характеристики, используемые при классификации, и избавиться от неважных (которые имеют меньшую дисперсию).

Уменьшение количества функций в машинном обучении играет действительно важную роль, особенно при работе с большими наборами данных.Фактически это может: ускорить обучение, избежать переобучения и, в конечном итоге, привести к лучшим результатам классификации благодаря уменьшению шума в данных.

На рисунке 4 показаны основные особенности, которые я определил с помощью SVM в базе данных диабета индейцев пима. Зеленым цветом показаны все характеристики, соответствующие отрицательным коэффициентам, а синим — положительным. Если вы хотите узнать об этом больше, весь мой код находится в свободном доступе в моих профилях Kaggle и GitHub.

Машина опорных векторов на Python.Эта статья представляет собой исчерпывающее руководство… | by Wajiha Urooj | Edureka

Машинное обучение — это революция нового века в компьютерную эру. Мы можем выполнять задачи, о которых можно только мечтать, с правильным набором данных и соответствующими алгоритмами для обработки данных для получения оптимальных результатов. В этой статье мы рассмотрим один из таких алгоритмов классификации в машинном обучении с использованием python, то есть Support Vector Machine в Python. В этом блоге рассматриваются следующие темы:

В этой статье мы рассмотрим один из таких алгоритмов классификации в машинном обучении с использованием python, то есть Support Vector Machine в Python. В этом блоге рассматриваются следующие темы:

- Введение в машинное обучение

- Что такое машина опорных векторов

- Как работает SVM?

- Ядра SVM

- Сценарии использования машины опорных векторов

- Пример SVM